Last Updated on április 8, 2024 10:47 de. by Laszlo Szabo / NowadAIs | Published on április 5, 2024 by Laszlo Szabo / NowadAIs

A Stanford Egyetem Octopus V2: GPT-4 – Főbb megjegyzések

- A Stanford Egyetem által kifejlesztett Octopus V2 egy olyan on-device nyelvi modell, amely nagy pontossággal és alacsony késleltetéssel javítja a mesterséges intelligencia-ügynökök szoftveres feladatainak teljesítményét.

- A magánélet védelmére és a költségekkel kapcsolatos aggályok kezelésére tervezett modell ideális az olyan peremeszközökhöz, mint az okostelefonok és a VR-headsetek.

- Kétlépcsős eljárást használ a funkcióhíváshoz, jobb pontosságot és hatékonyságot elérve.

- Speciális tokeneket alkalmaz a jobb funkciónév-előrejelzéshez, és súlyozott kereszt-entrópia veszteségfüggvénnyel kezeli az adathalmazok kiegyensúlyozatlanságát.

- A Gemma-2B modell segítségével képzett, teljes modell és Lora képzési módszerekkel.

Mesterséges intelligencia az eszközön a Stanford Egyetem által: Octopus V2

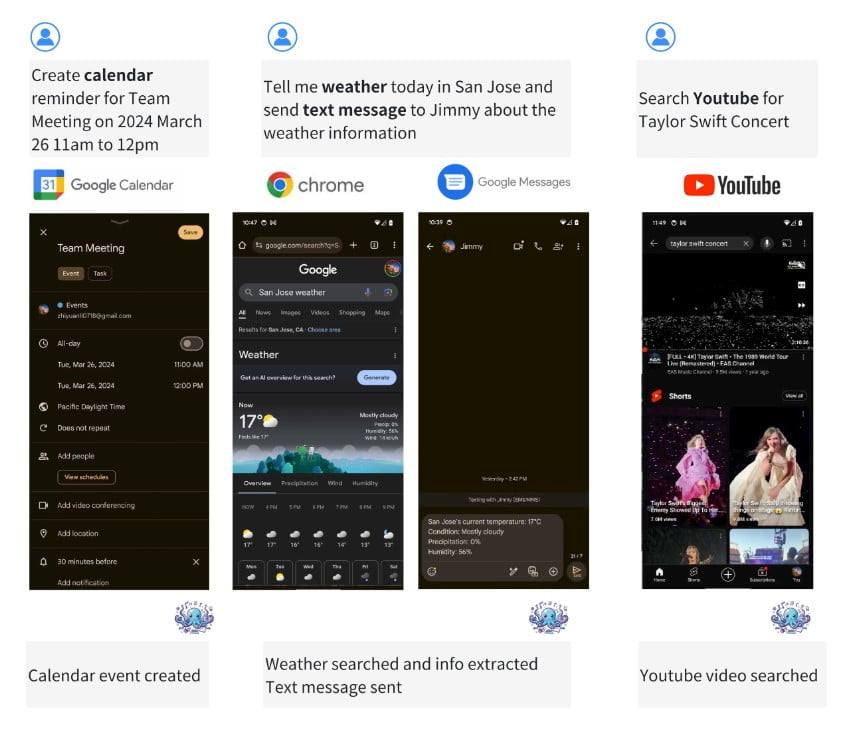

A mesterséges intelligencia-ügynökök és nyelvi modellek rohamosan fejlődő világában az Octopus V2 kiemelkedik a szuperügynökök készülékre telepített nyelvi modelljeként. A Stanford Egyetem egy csapata által kifejlesztett modell lehetővé teszi, hogy az AI-ügynökök a szoftverfeladatok széles körét, köztük a függvényhívásokat is kivételes pontossággal és csökkentett késleltetéssel hajtsák végre.

Az Octopus V2 megoldja a nagyméretű felhőalapú nyelvi modellekkel kapcsolatos adatvédelmi és költségproblémákat, így alkalmas az olyan peremeszközökön való telepítésre, mint az okostelefonok, autók, VR-headsetek és személyi számítógépek.

Az eszközön belüli nyelvi modellek iránti igény

A nyelvi modellek megváltoztatták a mesterséges intelligencia területét, lehetővé téve a természetes nyelvi feldolgozást és megértést. A felhőalapú modellekre támaszkodó funkcióhívás azonban olyan hátrányokkal jár, mint az adatvédelmi aggályok, a magas következtetési költségek és az állandó Wi-Fi-kapcsolat szükségessége. A kisebb, készüléken lévő modellek alkalmazása enyhítheti ezeket a problémákat, de ezek gyakran olyan kihívásokkal szembesülnek, mint a lassabb késleltetés és a korlátozott akkumulátor-üzemidő. Az Octopus V2 ezeket a kihívásokat kívánja leküzdeni egy hatékony és pontos, készüléken belüli nyelvi modell biztosításával.

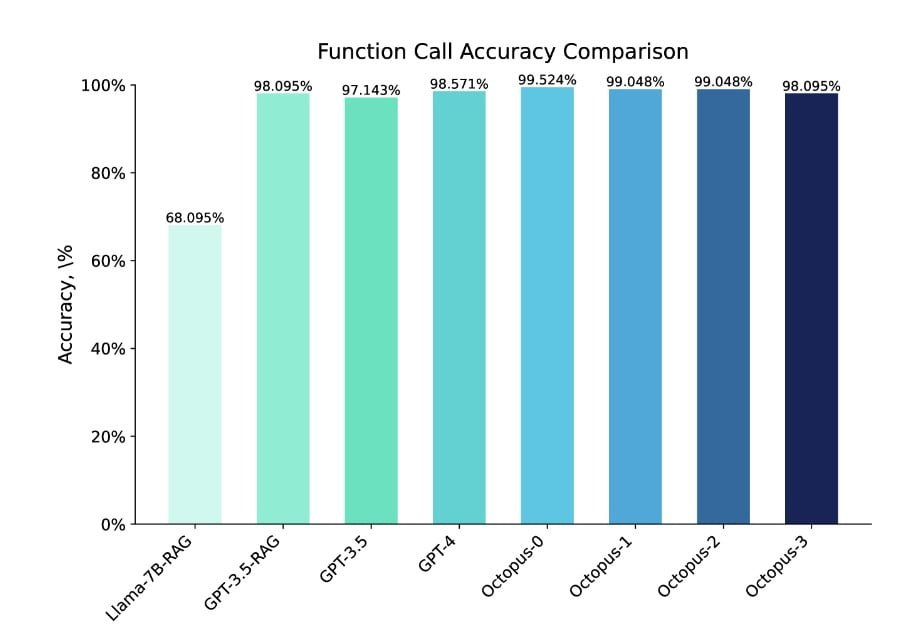

Octopus V2: A pontosság és a késleltetés növelése

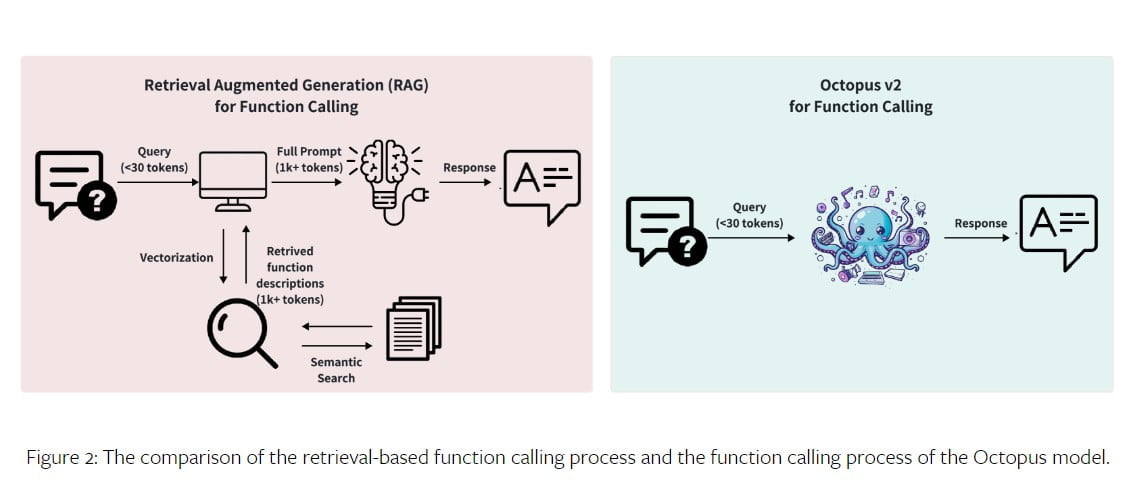

Az Octopus V2 modell mind pontosság, mind késleltetés tekintetében felülmúlja a GPT-4 teljesítményét. 2 milliárd paraméter esetén az Octopus V2 modell 95%-kal csökkenti a kontextus hosszát, ami gyorsabb és hatékonyabb függvényhívást tesz lehetővé. A modell funkcionális tokenekkel történő finomhangolásával és a funkcióleírásoknak a képzési adathalmazba való beépítésével az Octopus V2 modell más modellekhez képest jobb teljesítményt ér el a funkcióhívás terén. Sőt, a RAG-alapú függvényhívási mechanizmussal 35-szörös késleltetéssel felülmúlja a Llama-7B modellt.

Módszertan: Az ok-okozati nyelvi modell mint osztályozási modell

Az Octopus V2 modell kétlépcsős folyamatot alkalmaz a függvényhíváshoz: függvénykiválasztás és paramétergenerálás. A függvénykiválasztási szakaszban a modell egy osztályozási modellt alkalmaz, hogy pontosan kiválassza a megfelelő függvényt a rendelkezésre álló lehetőségek közül. Ez történhet visszakeresésen alapuló dokumentumkiválasztással vagy olyan autoregresszív modellekkel, mint a GPT.

A paramétergenerálási szakaszban a felhasználó lekérdezése és a funkció leírása alapján a kiválasztott funkció paramétereit hozzuk létre. Az Octopus V2 modell ezt a két szakaszt egyesíti egy egységes GPT modellstratégia segítségével, ami gyorsabb következtetési sebességet és rendszerkényelmet eredményez.

Adatgyűjtés és modellképzés

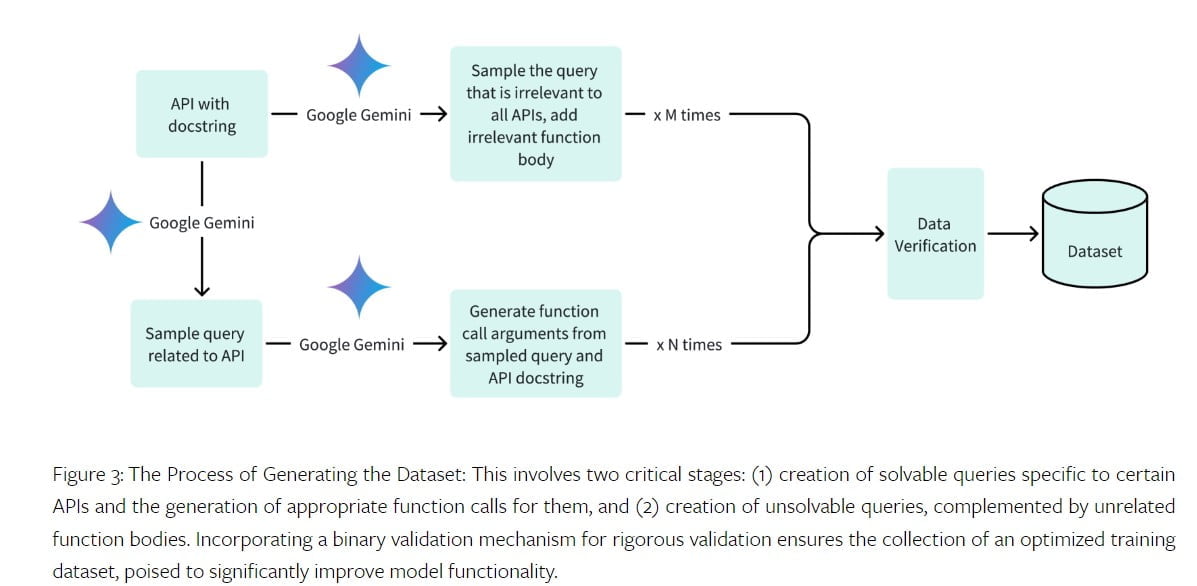

Az Octopus V2 modell képzéséhez elengedhetetlen egy kiváló minőségű adathalmaz. Az adatkészlet releváns lekérdezéseket, függvényhívási argumentumokat és függvényleírásokat tartalmaz. A Stanford Egyetem csapata különböző tartományokhoz gyűjtött adathalmazokat, köztük Android API-kat, jármű API-kat, Yelp API-kat és DoorDash API-kat. Az adatkészlet-generálási folyamat során pozitív lekérdezéseket és függvényhívási argumentumokat generáltak a megoldható lekérdezésekhez, valamint negatív mintákat a megoldhatatlan lekérdezésekhez. Az adatkészletet a Google Gemini API segítségével ellenőriztük, biztosítva a pontosságot és a teljességet.

Az Octopus V2 modell képzése a Gemma-2B előképzett modell és két különböző képzési módszer segítségével történt: teljes modellképzés és LoRA képzés. A teljes modellképzés során egy AdamW optimalizálót használtunk 5e-5 tanulási rátával és 10-es bemelegítési lépéssel. A LoRA képzés ezzel szemben 16-os rangot használt, és a LoRA-t a modell egyes moduljaira alkalmazta. Mindkét képzési módszer a legkorszerűbb eredményeket érte el a pontosság és a késleltetés tekintetében.

Ezenkívül az Octopus V2 modell képzési adathalmazának mérete beállítható a költséghatékonyság elérése érdekében a pontosság veszélyeztetése nélkül. A modell kisebb méretű, API-nként 100 és 1000 adatpont közötti adathalmazzal történő képzése még mindig magas pontossági arányokat eredményez, így a modell elérhetővé válik azon magánszemélyek számára, akik saját Octopus-modelleket szeretnének képezni.

Összehasonlítás és teljesítményértékelés

Az Octopus V2 modell átfogó teljesítményértékelésen és értékelésen ment keresztül, hogy felmérjük, mennyire hatékony a pontos funkcióhívások generálásában. A modell pontosságát és válaszidejét a szakterület vezető modelljeivel, például a GPT-4 és a GPT-3.5 modellekkel hasonlítottuk össze. Az Octopus V2 modell a pontosság tekintetében felülmúlta ezeket a modelleket, és az értékelő adathalmazban 99,524%-os pontosságot ért el.

A modell emellett jelentősen csökkentett késleltetési időt mutatott, egy függvényhívást 0,38 másodperc alatt fejezett be. Az Octopus V2 modell teljesítményét különböző tartományokban értékelték, többek között Android funkcióhívások, járműfunkcióhívások, Yelp API-k és DoorDash API-k esetében, bemutatva sokoldalúságát és alkalmazkodóképességét.

Finomhangolás speciális tokenekkel

Az Octopus V2 modell egyedülálló aspektusa a speciális tokenek beépítése a tokenizálóba és a nyelvi modell fejének bővítése. Ezek a speciális tokenek funkcióneveket jelölnek, és lehetővé teszik a pontos funkciónév-előrejelzést.

A speciális tokenek bevezetése által okozott kiegyensúlyozatlan adatkészlet kihívásának kezelésére a képzés során egy súlyozott kereszt-entrópia veszteségfüggvényt használunk. Ez a súlyozott veszteségfüggvény nagyobb súlyokat rendel a speciális tokenekhez, javítva ezzel a konvergenciát és a modell általános teljesítményét.

Következtetés és jövőbeli munkák

Az Octopus V2 modell jelentős előrelépést jelent a szuperügynökök számára készült, készüléken futó nyelvi modellek terén. Az a képessége, hogy csökkentett késleltetéssel képes pontos funkcióhívást végezni, alkalmassá teszi az alkalmazások széles körére, az okostelefonoktól a VR-headsetekig. A modell nagy pontossága és hatékonysága megnyitja az utat a mesterséges intelligencia-ügynökök jobb teljesítménye előtt a valós forgatókönyvekben.

A jövőben a további kutatás és fejlesztés a modell képességeinek bővítésére, új területek feltárására és teljesítményének optimalizálására összpontosíthat az egyes alkalmazásokhoz.

Fogalommeghatározások

- Octopus V2: A Stanford Egyetem által létrehozott, fejlett, eszközre telepített nyelvi modell, amelynek célja, hogy jelentősen javítsa a mesterséges intelligencia-ügynökök képességeit azáltal, hogy lehetővé teszi számukra a szoftverfeladatok példátlan pontosságú és sebességű végrehajtását.

- Stanford Egyetem: Egy tekintélyes kutatóegyetem, amely különböző területeken, többek között a mesterséges intelligencia és a számítástechnika területén elért jelentős hozzájárulásáról ismert.

- Készüléken működő nyelvi modellek: Olyan mesterséges intelligenciamodellek, amelyek közvetlenül helyi eszközökön, például okostelefonokon vagy számítógépeken működnek, felhőfeldolgozás nélkül, hangsúlyozva a magánélet védelmét és csökkentve az állandó internetkapcsolatra való utaltságot.

- API: Alkalmazásprogramozási interfész, a szoftverek és alkalmazások építéséhez szükséges protokollok és eszközök összessége, amely lehetővé teszi a különböző szoftverkomponensek közötti kommunikációt.

- Gemma-2B: Az Octopus V2 fejlesztése során használt, előzetesen betanított modell a magas minőségű képzési eredmények elérése érdekében.

- Lora Training: Olyan képzési módszertan, amely az alacsony rangú adaptációt alkalmazza egy mesterséges intelligenciamodell egyes moduljaira annak teljesítményének növelése érdekében, anélkül, hogy kiterjedt újratanításra lenne szükség.

Gyakran ismételt kérdések

- Mi különbözteti meg az Octopus V2-t a többi készülékre telepített nyelvi modelltől?

- Az Octopus V2 kiemelkedik a szoftverfeladatok széles körének figyelemre méltó pontossággal és csökkentett késleltetéssel történő elvégzésére való képességével, miközben a felhőalapú modellekkel kapcsolatos adatvédelmi és költségproblémákat is kezeli.

- Hogyan növeli az Octopus V2 az AI-ügynökök teljesítményét a valós alkalmazásokban?

- A kontextus hosszának 95%-os csökkentésével és a funkcionális tokenekkel történő finomhangolással az Octopus V2 lehetővé teszi, hogy az AI-ügynökök hatékonyabban hajtsák végre a funkcióhívásokat, és pontosságban és késleltetésben felülmúlják a korábbi modelleket, például a GPT-4 és a Llama-7B modelleket.

- Milyen előnyökkel jár az Octopus V2 használata a fejlesztők és a végfelhasználók számára?

- A fejlesztők számára az Octopus V2 egy hatékony eszközt kínál a szélsőséges eszközökre reagáló és képes AI-alkalmazások létrehozásához. A végfelhasználók számára a gyorsabb, pontosabb interakciókat jelentenek az AI-ügynökökkel, javítva az általános felhasználói élményt.

- Alkalmazható-e az Octopus V2 különböző tartományokhoz és alkalmazásokhoz?

- Igen, az Octopus V2 sokoldalúságát különböző tartományokban, többek között Android API-kban, jármű API-kban és Yelp API-kban is bizonyították, bemutatva alkalmazkodóképességét és hatékonyságát különböző környezetben.

- Milyen jövőbeli fejlesztésekre számíthatunk az Octopus V2 modelltől?

- A jövőbeli kutatások az Octopus V2 képességeinek további tartományokra való kiterjesztésére, a teljesítményének optimalizálására az egyes alkalmazásokhoz, valamint a pontosság és hatékonyság további növelése érdekében új módszerek feltárására fognak összpontosítani.