Last Updated on május 24, 2024 1:34 du. by Laszlo Szabo / NowadAIs | Published on május 24, 2024 by Laszlo Szabo / NowadAIs

Cohere Aya-23 modellek: LLM 23 nyelven – Főbb megjegyzések

- Aya-23 modellek: A Cohere For AI legújabb többnyelvű nagy nyelvi modelljei.

- 8B és 35B paraméterek: Két, különböző számítási képességeknek megfelelő változat.

- Többnyelvű ökoszisztéma: Az Aya Collectionre épül, amely 114 nyelvet fed le.

- Teljesítmény: Jelentős javulás a korábbi modellekhez, például az Aya-101-hez képest.

- Nyílt súlyok kiadása: Kutatásra és fejlesztésre rendelkezésre álló modellek.

- Globális együttműködés: 119 ország több mint 3000 kutatója járult hozzá.

- Nyelvi képességek: Kiemelkedő teljesítmény olyan feladatokban, mint az összegzés, fordítás és megértés.

Bevezetés

A természetes nyelvfeldolgozás (NLP) gyorsan fejlődő területén a különböző nyelvek hatékony kezelésének képessége kulcsfontosságú határterület lett. A hagyományos NLP-modellek gyakran nehezen tudják kezelni a többnyelvű kommunikációban rejlő árnyalatokat és összetettséget, ami akadályozza széles körű elterjedésüket. A Cohere For AI úttörő munkája nyomán azonban új megoldás született : az Aya-23 többnyelvű nyelvi modellcsalád.

Aya-23: A többnyelvű szakadék áthidalása

A mai napon elindítjuk az Aya 23-at, a legmodernebb többnyelvű 8B és 35B nyílt súlyok kiadását

.

Az Aya 23 egy nagy teljesítményű, előre betanított modellt párosít a legújabb Aya-adatkészlettel, így a kutatóközösség számára is elérhetővé teszi a többnyelvű generatív mesterséges intelligencia áttöréseit.🌍https://t.co/9HsmypAbBb pic.twitter.com/TqHlNfh6zf– Cohere For AI (@CohereForAI) May 23, 2024

ACohere For AI, a kanadai Cohere vállalati AI startup nonprofit kutatási ága bemutatta az Aya-23 modelleket – a többnyelvű nagy nyelvi modellek (LLM ) élvonalbeli sorozatát, amely forradalmasíthatja az NLP területét. Az Aya-23 a korábbi Aya-101 modell sikerére épül, amely lenyűgöző 101 nyelvet fedett le, de a hangsúlyt stratégiai váltással helyezi át.

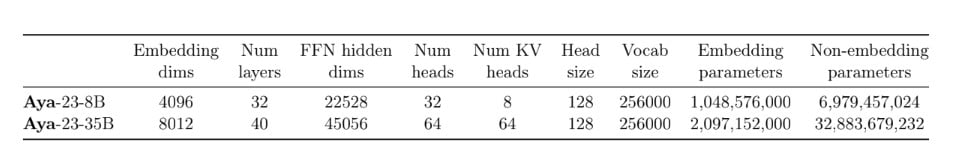

Aya-23-8B: Hatékonyság és hozzáférhetőség

A 8 milliárd paramétert tartalmazó Aya-23-8B modellt úgy tervezték, hogy egyensúlyt teremtsen a teljesítmény és a hozzáférhetőség között. A modell architektúrájának optimalizálásával és az olyan fejlett technikák kihasználásával, mint a csoportosított lekérdezési figyelem és a rotációs pozicionális beágyazás, az Aya-23-8B a legkorszerűbb többnyelvű képességeket nyújtja, anélkül, hogy kiterjedt számítási erőforrásokra lenne szükség. Ez ideális választássá teszi a szerényebb hardverfelszereltséggel dolgozó kutatók és fejlesztők számára.

Aya-23-35B: Páratlan nyelvi képességek

Azok számára, akik rendelkeznek a teljes potenciál kihasználásához szükséges számítási kapacitással, az Aya-23-35B modell, amely lenyűgöző 35 milliárd paraméterrel büszkélkedhet, páratlan nyelvi képességeket kínál. A Cohere Command R modelljének alapjaira építve az Aya-23-35B egy sor olyan fejlesztést tartalmaz, amelyek növelik a teljesítményét az összetett többnyelvű feladatokban, beleértve a természetes nyelvi megértést, az összegzést és a fordítást.

Az Aya többnyelvű ökoszisztémája

Az Aya-23 modellek nem pusztán önálló eredmények; ezek a Cohere For AI szélesebb körű Aya kezdeményezésének csúcspontját jelentik – egy 119 ország több mint 3000 független kutatójának közös munkáját. Ez a globális kezdeményezés erőforrások gazdag ökoszisztémáját hozta létre, beleértve az Aya Collectiont, egy hatalmas, többnyelvű, 513 millió felszólítást és kitöltést tartalmazó, 114 nyelvet felölelő adathalmazt.

Az Aya Collection: A többnyelvű fejlődés elősegítése

Az Aya-gyűjtemény az Aya-23 modellek alapjául szolgál, mivel olyan változatos és kiváló minőségű képzési adathalmazt biztosít, amely lehetővé teszi, hogy a modellek a nyelvek széles skáláján kiemelkedő teljesítményt nyújtsanak. E kiterjedt erőforrás kihasználásával az Aya-23 modellek kiváló teljesítményt nyújtanak más, széles körben használt többnyelvű modellekhez, például a Gemma, a Mistral és a Mixtral modellekhez képest.

Aya-101: Az alapok megteremtése

Míg az Aya-23 modellek a Cohere For AI többnyelvűséggel kapcsolatos erőfeszítéseinek legújabb állomását képviselik, nem szabad figyelmen kívül hagyni az úttörő Aya-101 modellt sem. A 2024 februárjában kiadott Aya-101 önmagában is úttörő eredmény volt, mivel példátlanul sok 101 nyelvet fedett le, és új mércét állított fel a tömegesen többnyelvű nyelvi modellezés terén.

Az Aya-23 teljesítményelőnyei

Az Aya-23 modellek szigorú értékelésen estek át, amely megmutatta figyelemre méltó képességeiket a többnyelvű feladatokban. Elődjükhöz, az Aya-101-hez képest az Aya-23 modellek jelentős javulást mutatnak számos diszkriminatív és generatív feladatban, a 8 milliárd paraméteres változat pedig a legjobb többnyelvű teljesítményt nyújtja.

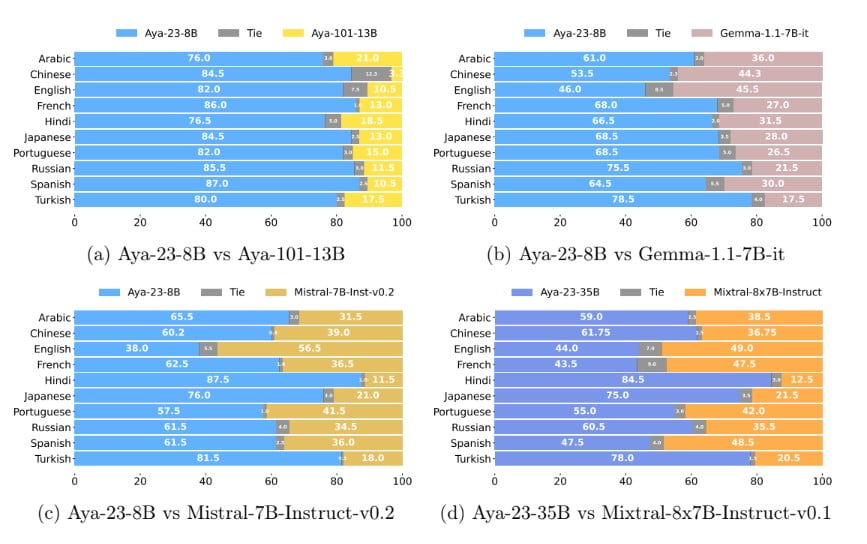

A versenytársaknál jobb teljesítmény

Más, széles körben használt nyílt forráskódú modellekkel, például a Gemma, a Mistral és a Mixtral modellekkel összehasonlítva az Aya-23 modellek következetesen felülmúlják társaikat. A kutatók a diszkriminatív feladatokban akár 14%-os, a generatív feladatokban 20%-os, a többnyelvű matematikai gondolkodásban pedig figyelemre méltó, 41,6%-os javulásról számolnak be az Aya-101-hez képest.

Konzisztens minőség nyelvek között

Az Aya-23 modellek egyik kiemelkedő jellemzője, hogy a célnyelvtől függetlenül képesek magas szintű konzisztenciát és koherenciát fenntartani az általuk generált szövegben. Ez döntő előny a zökkenőmentes többnyelvű támogatást igénylő alkalmazások, például a fordítási szolgáltatások, a tartalomkészítés és a társalgási ügynökök számára.

Hozzáférhetőség és nyílt forráskódú elkötelezettség

A Cohere For AI elkötelezettsége a többnyelvű mesterséges intelligencia kutatásának előmozdítása iránt túlmutat az Aya-23 modellek technikai eredményein. A vállalat összehangolt erőfeszítéseket tett annak biztosítására, hogy ezek a nagy teljesítményű eszközök a kutatók és fejlesztők széles köre számára hozzáférhetőek legyenek.

Nyílt súlyok kiadása

A Cohere For AI kiadta az Aya-23-8B és az Aya-23-35B modellek nyílt súlyait, lehetővé téve a kutatóközösség számára, hogy tovább vizsgálja, finomhangolja és tovább építse ezeket a legkorszerűbb többnyelvű modelleket. Ez a nyílt forráskódú megközelítés összhangban van a vállalat azon küldetésével, hogy demokratizálja a hozzáférést a legmodernebb AI-technológiához.

A kutatói közösség támogatása

A nyílt súlyok biztosításával a Cohere For AI célja, hogy inspirálja és képessé tegye a kutatókat és a gyakorlati szakembereket a többnyelvű mesterséges intelligencia határainak feszegetésére. Ez a gesztus nemcsak a terület fejlődését segíti elő, hanem elősegíti az együttműködés szellemét is, ahol a globális kutatóközösség közösen dolgozhat a technológiai nyelvi korlátok kihívásainak megoldásán.

Az Aya kezdeményezés: Paradigmaváltás a többnyelvű mesterséges intelligencia területén

Az Aya-23 modellek nem pusztán a Cohere For AI kutatási erőfeszítéseinek legújabb termékei, hanem egy szélesebb körű kezdeményezés részei, amely átformálja a többnyelvű mesterséges intelligencia területét. Az Aya projekt, amelyben 119 ország több mint 3000 független kutatója vett részt, paradigmaváltást jelent abban, ahogyan a gépi tanulással foglalkozó közösség a többnyelvű nyelvi modellezés kihívásait megközelíti.

A többnyelvű mesterséges intelligencia demokratizálása

A világ minden tájáról érkező kutatók sokféle nézőpontjának és szakértelmének kihasználásával az Aya kezdeményezés a tudás és az erőforrások gazdag tárházát hozta létre, amely mostantól a szélesebb közösség számára is elérhető. Ez az együttműködésen alapuló megközelítés tette lehetővé az Aya-23-hoz hasonló modellek kifejlesztését, amelyek a világ népességének közel felének nyelvi igényeit elégítik ki.

Az alulszolgáltatott nyelvek megerősítése

“Értékelésünkben 23 nyelvre összpontosítunk, amelyeket az új Aya modellcsalád lefed. Ez a 23 nyelv a következő: Arab, kínai (egyszerűsített és hagyományos), cseh, holland, angol, francia, német, görög, héber, hindi, indonéz, olasz, japán, koreai, perzsa, holland, lengyel, portugál, román, orosz, spanyol, török, ukrán és vietnámi.”

olvasható a Cohere lapjában .

Az Aya kezdeményezés egyik fő mozgatórugója az a felismerés, hogy a mesterséges intelligencia területén történelmileg egy maroknyi nyelv dominált, így sok más nyelv alulreprezentált és alulhasznosított maradt. Az Aya-23 modellek, amelyek 23 nyelvet támogatnak, köztük ritka és alacsony forrású nyelveket is, jelentős lépést jelentenek az egyensúlyhiány megszüntetése és annak biztosítása felé, hogy a generatív mesterséges intelligencia gyorsan fejlődő világában több nyelvet kezeljenek első osztályú állampolgárként.

A többnyelvű mesterséges intelligencia jövője: az Aya-23 és azon túl

Az Aya-23 modellek bevezetése sarkalatos pontot jelent a többnyelvű mesterséges intelligencia kutatásának és fejlesztésének folyamatban lévő útján. Ahogy a terület tovább fejlődik, az Aya-23 modellek és a tágabb értelemben vett Aya kezdeményezés a fejlődés jelzőfényei, amelyek arra ösztönzik a kutatókat és a gyakorlati szakembereket, hogy feszegessék a természetes nyelvi feldolgozás határait.

A folyamatos fejlesztés ösztönzése

A Cohere For AI elkötelezettsége az Aya projekt mellett biztosítja, hogy a többnyelvű mesterséges intelligencia fejlődésének útja nem ér véget az Aya-23 modellekkel. A vállalat folyamatos befektetései a kutatásba és fejlesztésbe, valamint a globális Aya közösség közös erőfeszítései kétségtelenül további finomításokhoz, fejlesztésekhez és áttörésekhez fognak vezetni az elkövetkező években.

Következtetés

A Cohere For AI Aya-23 modelljei úttörő előrelépést jelentenek a többnyelvű NLP világában. Az Aya ökoszisztéma erejét kihasználva ezek a modellek új mércét állítottak fel a teljesítmény, a hozzáférhetőség és a nyelvi lefedettség terén. Ahogy a kutatóközösség elfogadja az Aya-23 modellek nyílt forráskódú jellegét, a többnyelvű mesterséges intelligencia jövője a határtalan innováció, az együttműködés és a különböző nyelvek és kultúrák megerősítése ígérkezik világszerte.

Definíciók

- Cohere Aya-23 modellek: A Cohere For AI által kifejlesztett, legkorszerűbb többnyelvű nagy nyelvi modellek sorozata, amelyet különböző nyelvek és összetett NLP-feladatok kezelésére terveztek.

- Természetes nyelvi feldolgozás (NLP): A mesterséges intelligencia azon területe, amely a számítógépek és az emberek közötti, természetes nyelven keresztüli interakcióra összpontosít.

- LLM modellek: Nagyméretű nyelvi modellek, amelyek gépi tanulási technikákat használnak az emberi nyelv nagy léptékű megértésére, generálására és fordítására.

- Mesterséges intelligencia ökoszisztéma: A mesterséges intelligencia eszközeinek, erőforrásainak és kutatásainak összekapcsolt környezete, amely támogatja a mesterséges intelligencia fejlesztését és alkalmazását.

- Aya Collection: Egy hatalmas többnyelvű adathalmaz, amely 114 nyelv 513 millió felszólításából és kitöltéséből áll, és amelyet az Aya-23 modellek képzéséhez használnak.

- Gemma, Mistral és Mixtral: Más, széles körben használt többnyelvű modellek, amelyeket az Aya-23 különböző NLP-feladatokban felülmúl.

Gyakran ismételt kérdések

- Milyenek a Cohere Aya-23 modellek? A Cohere Aya-23 modelljei fejlett, többnyelvű, nagyméretű nyelvi modellek, amelyeket a nyelvek és NLP-feladatok széles körének kezelésére terveztek. Két változatban kaphatók: Aya-23-8B és Aya-23-35B, 8 milliárd, illetve 35 milliárd paraméterrel.

- Miben jobbak az Aya-23 modellek a korábbi változatoknál, például az Aya-101-nél? Az Aya-23 modellek jelentős javulást mutatnak az Aya-101-hez képest, és nagyobb teljesítményt nyújtanak olyan feladatokban, mint a természetes nyelvi megértés, az összegzés és a fordítás. Emellett jobb többnyelvű matematikai érvelést és általános nyelvi képességeket is kínálnak.

- Mi az az Aya Collection és hogyan támogatja az Aya-23 modelleket? Az Aya Collection egy átfogó többnyelvű adathalmaz, amely 513 millió felszólítást és kitöltést tartalmaz 114 nyelven. Ez szolgál az Aya-23 modellek képzési alapjául, lehetővé téve számukra, hogy kiválóan teljesítsenek különböző többnyelvű feladatokban.

- Miért fontos az Aya-23 modellek nyílt súlyú kiadása? A nyílt súlyok kiadása lehetővé teszi a kutatók és fejlesztők számára, hogy hozzáférjenek az Aya-23 modellekhez, finomhangolják azokat, és építsenek rájuk. Ez demokratizálja az élvonalbeli mesterséges intelligencia technológiához való hozzáférést, és elősegíti a többnyelvű NLP fejlesztését szolgáló együttműködési környezetet.

- Mi különbözteti meg az Aya-23 modelleket más többnyelvű modellektől, mint például a Gemma és a Mistral? Az Aya-23 modellek a generatív feladatokban akár 20%-kal, a többnyelvű matematikai következtetésekben pedig 41,6%-kal felülmúlják a Gemma, a Mistral és más többnyelvű modellek teljesítményét. A modellek nyelvek között konzisztens minőséget biztosítanak, és mind a nagy teljesítményű, mind a hozzáférhető felhasználási esetekre tervezték őket.