Last Updated on július 26, 2024 12:42 du. by Laszlo Szabo / NowadAIs | Published on július 24, 2024 by Laszlo Szabo / NowadAIs

a Mistral AI és az NVIDIA által kiadott 12B NeMo modell – legfontosabb megjegyzések

- A Mistral AI és az NVIDIA együttműködött a 12B NeMo modell létrehozásában.

- A NeMo 128 000 tokenből álló kontextusablakkal rendelkezik.

- A modell kiemelkedik az érvelés, az általános tudás és a kódolási pontosság terén.

- A NeMo-t úgy tervezték, hogy szabványos architektúrájának köszönhetően könnyedén leválthassa a Mistral 7B modellt.

- Nyílt forráskódú, Apache 2.0 licenc alatt elérhető, előre betanított ellenőrzőpontok.

- A NeMo teljesítményveszteség nélkül támogatja az FP8 következtetést.

- Globális és többnyelvű alkalmazásokra optimalizált.

- A NeMo tartalmazza a Tekken-t, a forráskód és számos nyelv esetében 30%-kal nagyobb tömörítési hatékonyságú tokenizálót.

NeMo AI modell az iparági nehézsúlyúak által

A Mistral AI vállalat nemrég mutatta be új 12B modelljét, a NeMo-t, amelyet az NVIDIA-val együttműködésben fejlesztettek ki. Ez a legújabb modell 128 000 tokenből álló kontextusablakkal rendelkezik, és állítólag a mérettartományán belül kiváló eredményeket ér el az érvelés, az általános tudás és a kódolási pontosság terén.

A Mistral AI és az NVIDIA közötti partnerség olyan modellt eredményezett, amely nemcsak a teljesítmény határait tágítja, hanem a kényelmet is előtérbe helyezi. A Mistral NeMo-t úgy alkották meg, hogy a szabványos architektúra használatának köszönhetően könnyedén lecserélje a Mistral 7B-t használó meglévő rendszereket.

A NeMo AI modell teljesítménye

A Mistral AI nemrégiben nagyszabású döntést hozott a modelljük használatának és továbbfejlesztésének előmozdítására azzal, hogy az Apache 2.0 licenc alatt hozzáférést biztosít az előre betanított ellenőrzőpontokhoz és az utasításokkal hangolt ellenőrzőpontokhoz. A nyílt forráskódú elérhetőségnek ez a megközelítése várhatóan mind a kutatók, mind a vállalkozások figyelmét felkelti majd, ami potenciálisan felgyorsíthatja a modell különböző alkalmazásokba való integrálását.

A Mistral NeMo egyik legfontosabb jellemzője, hogy a képzés során képes figyelembe venni a kvantálást, ami lehetővé teszi az FP8 következtetést a teljesítmény feláldozása nélkül. Ez a funkció rendkívül hasznos lehet a nagyméretű nyelvi modellek hatékony megvalósítását célzó szervezetek számára.

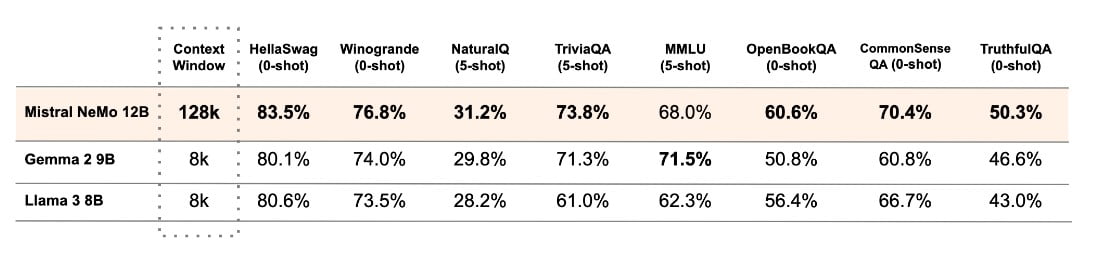

A Mistral AI elvégezte a Mistral NeMo alapmodell és két másik nyílt forráskódú, előre betanított modell, nevezetesen a Gemma 2 9B és a Llama 3 8B teljesítményének elemzését, és összehasonlította teljesítményüket.

A modell teljesítményét globális és többnyelvű alkalmazásokban való használatra optimalizálták. Képzése a funkcióhívásra összpontosít, és széles kontextusablakkal rendelkezik, így különösen jól használható különböző nyelveken, például angol, francia, német, spanyol, olasz, portugál, kínai, japán, koreai, arab és hindi nyelven.

A Tekken

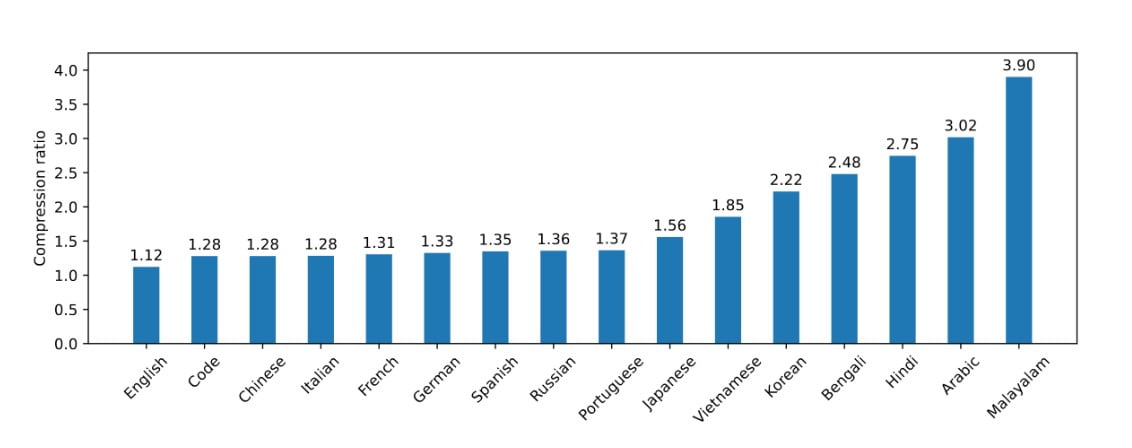

A Mistral NeMo nemrég indította el a Tekkent, egy újszerű tokenizálót, amely a Tiktokenre épül. Ezt az új tokenizálót több mint 100 nyelvből álló változatos készleten képezték ki. A Tekken mind a természetes nyelvű szövegek, mind a forráskódok esetében továbbfejlesztett tömörítési képességekkel büszkélkedhet, felülmúlva a korábbi Mistral modellekben használt SentencePiece tokenizáló teljesítményét. A vállalat szerint a Tekken 30%-kal nagyobb tömörítési hatékonyságot tud elérni a forráskód és számos széles körben beszélt nyelv esetében, a koreai és az arab nyelv esetében pedig még jelentősebb javulást ért el.

A Mistral AI szerint a Tekken a Llama 3 tokenizálóhoz képest a nyelvek mintegy 85%-ánál magasabb szövegtömörítési teljesítményt nyújt. Ez potenciálisan versenyelőnyt jelenthet a Mistral NeMo számára a többnyelvű alkalmazásokban.

A modell súlyai mostantól elérhetők a HuggingFace oldalon mind az alap-, mind az oktatóváltozat esetében. A fejlesztők a Mistral NeMo felfedezését a mistral-inference eszköz használatával és a mistral-finetune segítségével történő módosításával kezdhetik el. A Mistral platform felhasználói számára a modell open-mistral-nemo néven érhető el.

Az NVIDIA-val való partnerség elismeréseként a Mistral NeMo az ai.nvidia.com oldalon NVIDIA NIM inference microservice-ként is elérhető. Ez a felvétel megkönnyítheti a bevezetési folyamatot azon vállalatok számára, amelyek már használják az NVIDIA AI ökoszisztémáját.

A Mistral NeMo bevezetése jelentős előrelépést jelent a fejlett AI-modellek mindenki számára elérhetővé tételében. Ez a Mistral AI és az NVIDIA által kifejlesztett modell nagy teljesítményt és többnyelvű képességeket kínál, valamint nyíltan elérhető, így sokoldalú megoldást jelent a különböző iparágakban és kutatási területeken történő különféle AI-felhasználásokhoz.

Definíciók

- LLM hallucináló: Amikor a nagy nyelvi modellek hihető, de helytelen vagy értelmetlen kimeneteket generálnak.

- HaluBench: Egy benchmark-adatkészlet, amelyet a hallucinációk felismerésében használt AI-modellek pontosságának értékelésére használnak, és amely különböző valós témákat fed le.

- PubMedQA adatállomány: A mesterséges intelligenciamodellek értékelésére szolgáló adathalmaz az orvosi kérdésmegoldás területén, amely orvosi kontextusokban biztosítja a pontosságot.

- FSDP gépi tanulási technika: Fully Sharded Data Parallelism, egy olyan technika, amelyet a nagyméretű nyelvi modellek képzésének hatékonyságának és skálázhatóságának javítására használnak az adatok és a számítások több GPU-ra történő elosztásával.

Gyakran ismételt kérdések

1. Mi a Mistral AI NeMo modellje? A Mistral AI által készített NeMo Model egy 12 milliárd paraméteres mesterséges intelligencia modell, amelyet az NVIDIA-val együttműködve fejlesztettek ki, és amelyet úgy terveztek, hogy kiemelkedjen az érvelés, az általános tudás és a kódolási pontosság terén.

2. Miben különbözik a NeMo Model a korábbi modellektől, például a Mistral 7B-től? A NeMo lényegesen nagyobb, 128 000 tokenből álló kontextusablakot kínál, valamint jobb teljesítményt az érvelés és a kódolás terén, így a Mistral 7B kiváló helyettesítője.

3. Melyek a NeMo legfontosabb jellemzői? A NeMo nagy kontextusablakot, FP8 következtetés támogatását, többnyelvű képességeket tartalmaz, és az új Tekken tokenizálót használja a jobb tömörítési hatékonyság érdekében.

4. Hogyan kezeli a NeMo a többnyelvű alkalmazásokat? A NeMo globális alkalmazásokra optimalizált, több nyelvet támogat, például angol, francia, német, spanyol, olasz, portugál, kínai, japán, koreai, arab és hindi nyelvet.

5. Mi az a Tekken tokenizáló, és hogyan javítja a teljesítményt? A Tekken egy új tokenizáló, amely a Tiktokenre épül, és a korábbi tokenizátorokhoz képest 30%-kal nagyobb tömörítési hatékonyságot kínál természetes nyelvű szövegek és forráskódok esetében.