Last Updated on június 10, 2024 11:02 de. by Laszlo Szabo / NowadAIs | Published on június 10, 2024 by Laszlo Szabo / NowadAIs

Qwen 2-72B by Alibaba Cloud – Az AI Erőmű ami legyőzi a legjobb LLM modelleket, mint a Llama-3-70B – Fő pontok

- A Qwen 2-72B az Alibaba Cloud Qwen csapata által kifejlesztett nagy nyelvi modell zászlóshajója

- A nyelvi megértés, a többnyelvűség, a kódolás, a matematika és az érvelés terén a legmodernebb teljesítményt nyújtja

- A modell olyan fejlett architektúrális elemeket tartalmaz, mint a SwiGLU aktiválás, a QKV-előfeszítés és a csoportos lekérdezési figyelem

- A Qwen 2-72B-t kiterjedt többnyelvű adatokon képezték ki, és felügyelt finomhangolással és közvetlen preferencia-optimalizálással finomították

- Támogatja az akár 128K token hosszúságú kontextusokat, lehetővé téve a hosszú tartalmak kivételes kezelését

- A modell kiemelkedő biztonságot és felelősségtudatot mutat, és a vezető alternatívákat felülmúlja az érzékeny kérések kezelésében

Bevezetés

A mesterséges intelligencia gyorsan fejlődő területén a Qwen 2-72B bemutatása monumentális mérföldkőnek számít. Ez a kolosszális méretű nyelvi modell, amelyet az Alibaba Cloud látnok Qwen-csapata fejlesztett ki, igazi bravúrnak bizonyult, és elképesztően magasra tette a mércét a nyelvi megértés, a többnyelvűség és a feladatmegoldó képesség terén.

A Qwen 2-72B az aprólékos kutatás, a szigorú képzés és a kiválóságra való könyörtelen törekvés csúcspontja. Ez a 72 milliárd paraméterrel büszkélkedő óriásmodell aprólékosan kidolgozott, hogy a természetes nyelvi feldolgozástól és kódgenerálástól kezdve a matematikai következtetésekig és azon túl is számos területen kiemelkedő teljesítményt nyújtson.

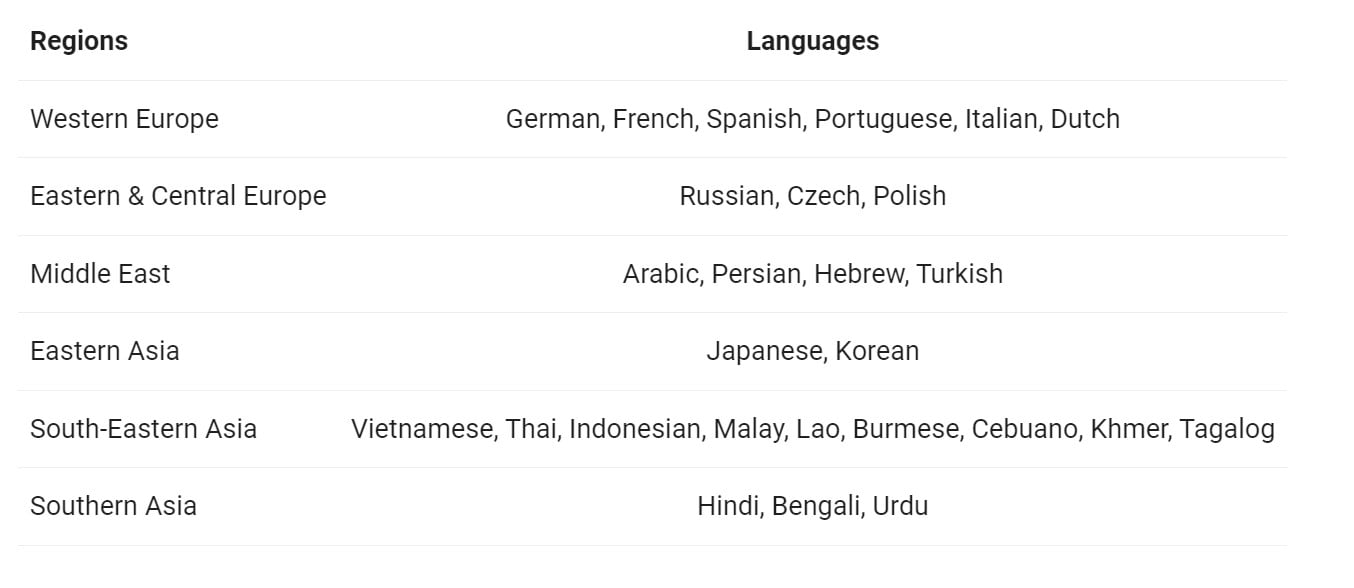

Többnyelvűség

A Qwen 2-72B egyik kiemelkedő jellemzője a kivételes többnyelvűség. Az angolon és kínai nyelven kívül 27 nyelvet felölelő, kiterjedt adathalmazon kiképzett modell mély és sokoldalú megértést alakított ki a különböző nyelvi tájakra. Ez a nyelvi sokoldalúság lehetővé teszi a Qwen 2-72B számára, hogy zökkenőmentesen navigáljon a többnyelvű kommunikációban, lebontva a korlátokat és elősegítve a globális együttműködést.

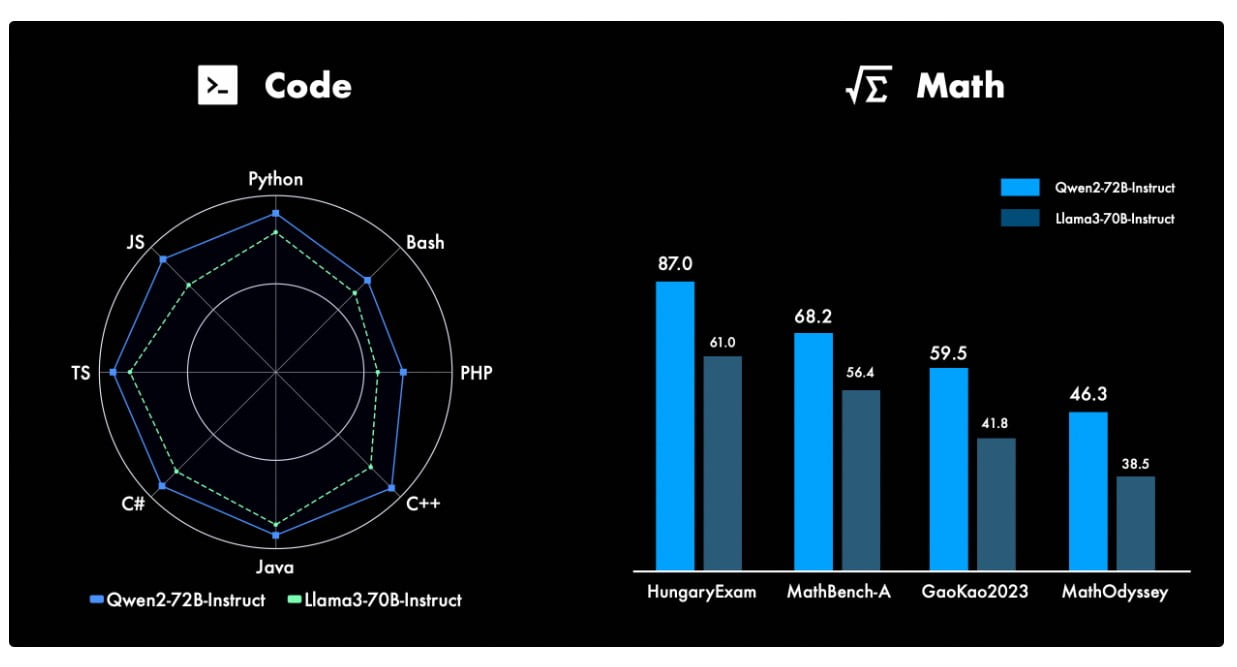

Kódolási és matematikai képességek

A Qwen 2-72B képességei messze túlmutatnak a természetes nyelvi feldolgozás területén. A modell figyelemre méltó képességekről tett tanúbizonyságot a kódolás és a matematika területén, új mércét állítva fel ezeken a rendkívül technikai területeken. A Qwen csapata aprólékos képzéssel és célzott finomítással a programozási nyelvek, algoritmusok és matematikai fogalmak mély megértésével ruházta fel a modellt, így az könnyedén megbirkózik a bonyolult kódolási feladatokkal és megoldja a bonyolult matematikai problémákat.

Hosszú formátumú tartalom elsajátítása

A Qwen 2-72B egyik kiemelkedő jellemzője a hosszú formátumú tartalmak kivételes kezelése. A modell akár 128 000 token hosszúságú szövegkörnyezet feldolgozására is képes, így kiválóan érti és koherens válaszokat generál a terjedelmes, több bekezdésből álló bemenetekre. Ez a képesség különbözteti meg a Qwen 2-72B-t, és értékes eszközzé teszi az olyan alkalmazásokban, ahol a hosszú szövegek részletes, árnyalt megértése a legfontosabb.

Biztonság és felelősség

Egy olyan korban, amikor a mesterséges intelligencia technológia felelősségteljes fejlesztése kiemelkedő fontosságú, a Qwen 2-72B kiemelkedik a biztonság és az etikai megfontolások iránti rendíthetetlen elkötelezettségével. A kiterjedt tesztelés bebizonyította, hogy a modell képes eligazodni az érzékeny kérések és tartalmak között, és következetesen az emberi értékekkel összhangban lévő, káros vagy etikátlan elemektől mentes kimeneteket produkál.

Qwen 2-72B működés közben

A Qwen 2-72B sokoldalúsága valóban lélegzetelállító, a modell képes zökkenőmentesen átváltani a feladatok és alkalmazások széles skálája között. A természetes nyelvi generálástól és a kérdések megválaszolásától a kódértelmezésig és a matematikai problémamegoldásig ez az AI-erőmű bizonyította, hogy igazi mindenes.

Telepítés és integráció

A Qwen 2-72B tervezésekor a skálázhatóságot és a hozzáférhetőséget tartották szem előtt, így kiválóan alkalmas a platformok és felhasználási esetek széles skáláján történő telepítésre. A modell integrációja olyan vezető keretrendszerekkel, mint a Hugging Face Transformers és a ModelScope, biztosítja, hogy a fejlesztők és a kutatók könnyedén kihasználhassák képességeit, és új lehetőségeket tárjanak fel saját területeiken.

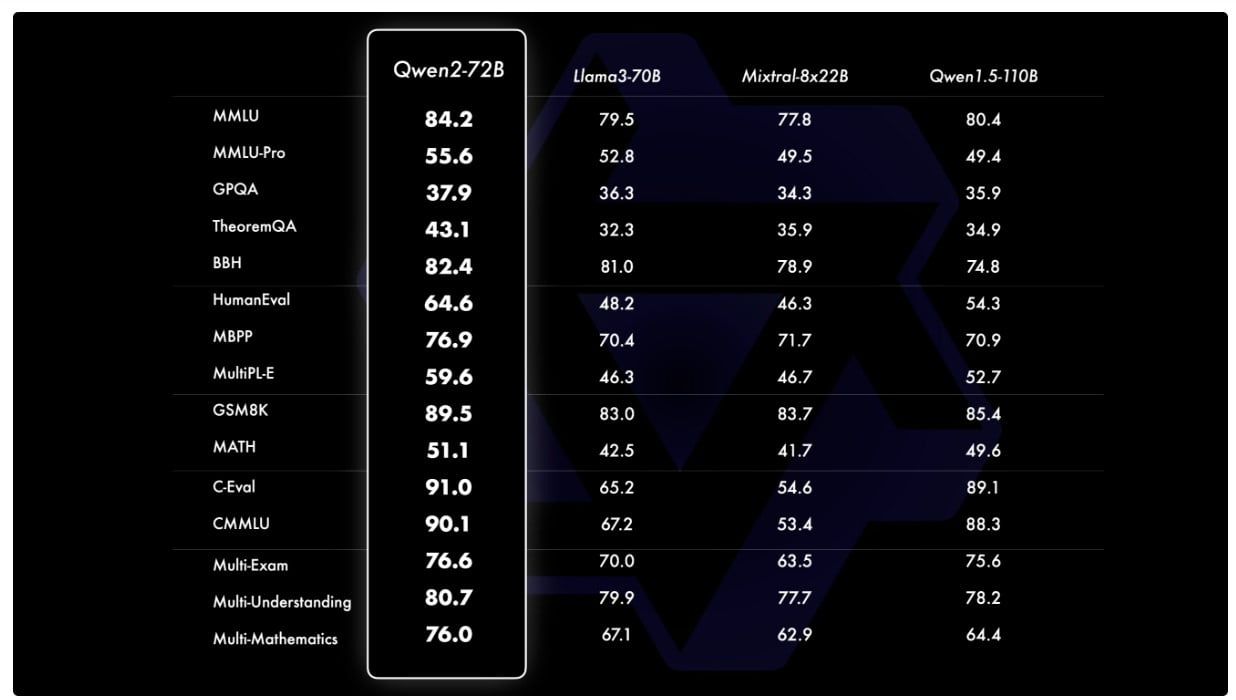

Benchmarking és teljesítmény

A szigorú tesztelés és értékelés következetesen bizonyította a Qwen 2-72B kiváló teljesítményét a benchmarkok széles skáláján. A többi legkorszerűbb modellel, például a Llama-3-70B-vel való közvetlen összehasonlításban a Qwen 2-72B modell egyértelműen az élen végzett, megmutatva páratlan képességeit olyan területeken, mint a természetes nyelvi megértés, a tudásszerzés és a feladatmegoldó képesség.

Az előttünk álló út

Mivel a Qwen 2-72B modell továbbra is lenyűgözi a mesterséges intelligencia közösségét, a jövő óriási ígéreteket tartogat. A Qwen csapatának az innováció iránti rendíthetetlen elkötelezettsége és a kiválóság iránti lankadatlan törekvése azt sugallja, hogy ez csupán egy új korszak kezdete a nagyméretű nyelvi modellek fejlesztésében. A folyamatos finomításokkal, bővítésekkel és a multimodális képességek feltárásával a Qwen 2-72B készen áll arra, hogy újradefiniálja a mesterséges intelligencia világában lehetséges határokat.

Definíciók

- Qwen 2-72B: Az Alibaba Cloud által kifejlesztett, 72 milliárd paraméterrel rendelkező, többnyelvű képességekben, kódolásban, matematikában és hosszú tartalmak kezelésében kiemelkedő, korszerű nagy nyelvi modell.

- SwiGLU: A neurális hálózatokban használt aktiválási függvénytípus, amely fokozza a modell komplex minták tanulására való képességét.

- QKV torzítás: A transzformációs modellekben a lekérdezési, kulcs- és értékvektorokban lévő torzító kifejezésekre utal, amelyek javítják a figyelmi mechanizmusokat.

- HungaryExam: Egy benchmarking adathalmaz vagy eszköz, amelyet a mesterséges intelligencia modellek teljesítményének értékelésére használnak a nyelvi megértésben és a kapcsolódó feladatokban.

- MMLU teljesítménymérők: A nagyméretű nyelvi modellek teljesítményének értékelésére használt metrikák a Massive Multitask Language Understanding (MMLU) benchmarkon.

- MIxtral-8x LLM modell: Egy másik nagy nyelvi modell, amely összehasonlítási pontként szolgál a Qwen 2-72B képességeinek értékeléséhez.

- SwiGLU aktiválás: A Qwen 2-72B-ben használt speciális aktiválási függvény, amely hozzájárul a fejlett tanulási képességekhez.

- QKV Bias: A modell teljesítményének növelése érdekében a lekérdezés, a kulcs és az érték kivetítésekhez hozzáadott torzító kifejezések a figyelemmechanizmusokban.

Gyakran ismételt kérdések

K: Mi különbözteti meg a Qwen 2-72B-t a többi nagy nyelvi modelltől? V: A Qwen 2-72B számos kulcsfontosságú megkülönböztető tényezővel büszkélkedhet, beleértve a legmodernebb architektúrális kialakítást, a kivételes többnyelvű képességeket és a páratlan teljesítményt a kódolás és a matematika terén. Emellett a modell hosszú, akár 128 000 tokenig terjedő tartalmak kezelésére való képessége, valamint a biztonság és a felelős fejlesztés iránti erős elkötelezettsége különbözteti meg a versenytársaktól.

K: Hogyan viszonyul a Qwen 2-72B teljesítménye más vezető modellekhez? V: A szigorú összehasonlító tesztek következetesen bizonyították a Qwen 2-72B fölényét más korszerű modellekkel, például a Llama-3-70B-vel szemben. A Qwen 2-72B modell az értékelések széles skáláján felülmúlta társait, beleértve a természetes nyelvi megértést, a tudásszerzést és a feladatmegoldó képességeket.

K: Melyek azok a kulcsfontosságú építészeti újítások, amelyek lehetővé teszik a Qwen 2-72B lenyűgöző képességeit? V: A Qwen 2-72B olyan architekturális elemeket tartalmaz, mint a SwiGLU aktiválás, a figyelem QKV torzítás és a csoportos lekérdezési figyelem. Ezek a fejlesztések nemcsak a modell nyers számítási teljesítményét növelik, hanem árnyalt nyelvi megértéssel is felruházzák, lehetővé téve, hogy a legösszetettebb és legkétszínűbb feladatokat is páratlan pontossággal oldja meg.

K: Hogyan különbözteti meg a Qwen 2-72B-t a többnyelvűség? V: A Qwen 2-72B kivételes többnyelvű képességei a Qwen csapatának a globális együttműködés előmozdítása és a nyelvi korlátok lebontása iránti elkötelezettségét bizonyítják. Az angolon és kínai nyelven kívül 27 nyelvet felölelő, kiterjedt adathalmazon képzett modell mély és sokoldalú megértést alakított ki a különböző nyelvi tájakról, lehetővé téve számára a zökkenőmentes navigációt a többnyelvű kommunikációban.

K: Milyen intézkedéseket tettek a Qwen 2-72B biztonságának és felelősségének biztosítása érdekében? V: A Qwen csapata nagy hangsúlyt fektetett a Qwen 2-72B felelős fejlesztésére. A kiterjedt tesztelés bebizonyította, hogy a modell képes navigálni az érzékeny kérések és tartalmak között, következetesen olyan kimeneteket produkálva, amelyek összhangban vannak az emberi értékekkel és mentesek a káros vagy etikátlan elemektől. A biztonság és az etikai megfontolások iránti elkötelezettség a Qwen 2-72B-t felelős és megbízható mesterséges intelligencia megoldásként különbözteti meg.