Last Updated on octubre 18, 2024 11:37 am by Laszlo Szabo / NowadAIs | Published on octubre 18, 2024 by Laszlo Szabo / NowadAIs

Nuevos modelos de inteligencia artificial Ministral 3B y 8B que podrían sustituir al ChatGPT en tu teléfono – Notas clave

- Ministral 3B y 8B pueden procesar 128.000 tokens a la vez, lo suficiente para entender un libro entero de una sola vez

- Ambos modelos funcionan completamente offline en dispositivos locales, ofreciendo una protección de la privacidad sin igual

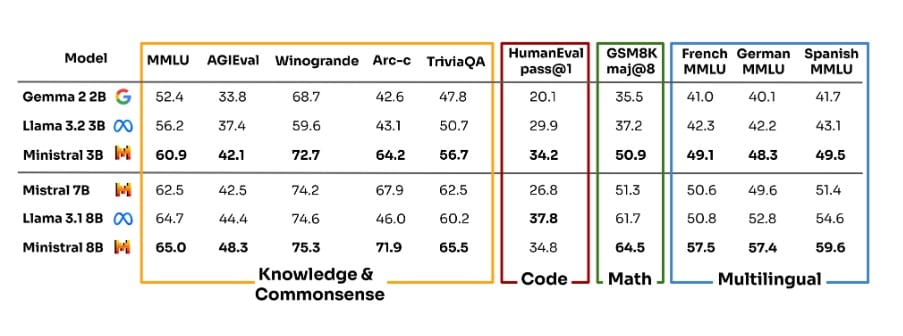

- A pesar de su pequeño tamaño, estos modelos superan a competidores de mayor tamaño en múltiples pruebas comparativas

Tigres diminutos: Los nuevos modelos de Mistral AI son muy potentes

¡Atención, tecnólogos! Mientras todo el mundo se obsesiona con los enormes modelos de IA que necesitan centros de datos más grandes que Manhattan, Mistral AI acaba de dar un golpe de efecto a toda la industria. Sus nuevos y maravillosos gemelos, Ministral 3B y Ministral 8B, son el equivalente en IA a meter un motor Ferrari en un coche compacto… ¡y vaya si ronronean!

Los nuevos chicos del barrio

Puede que Ministral 3B y Ministral 8B le parezcan unos adorables cachorritos de IA, pero no se deje engañar por su tamaño. De alguna manera, Mistral AI ha conseguido exprimir las capacidades de estos potentes y compactos cerebros. Estamos hablando de modelos que pueden ejecutarse en tu teléfono sin sudar, algo con lo que esas voluminosas IA basadas en la nube solo pueden soñar.

David contra Goliat: El juego de los números

Aquí es donde las cosas se ponen salvajes: Ministral 3B sólo tiene 3.000 millones de parámetros (de ahí su nombre), mientras que su hermano mayor, Ministral 8B, tiene 8.000 millones. Pero fíjate: ¡estos pequeños titanes de Mistral AI superan a algunos modelos que les doblan en tamaño! Es como ver a un boxeador ligero noquear al campeón de los pesos pesados.

La salsa secreta

Lo que deja boquiabierto a todo el mundo es cómo Mistral AI ha diseñado estos modelos. Ministral 3B y Ministral 8B no son sólo versiones reducidas de modelos más grandes, sino que han sido completamente rediseñados desde cero. Hablamos de una arquitectura de transformador densa que es más eficiente que su contable durante la temporada de impuestos.

Despiece de la bestia

Pongámonos empollones un momento. Tanto Ministral 3B como Ministral 8B pueden manejar una enorme ventana de contexto de 128.000 tokens. Para los no expertos en tecnología, eso es como ser capaz de leer y comprender un libro entero de un tirón. Mistral AI ha conseguido esta hazaña gracias a una ingeniería muy inteligente, que incluye un sofisticado “patrón de atención de ventana deslizante” en Ministral 8B que lo hace más rápido que un guepardo con cafeína.

El juego de la privacidad

Aquí es donde Mistral AI realmente da en el clavo con Ministral 3B y Ministral 8B: la privacidad. Estos modelos pueden funcionar sin conexión alguna en su dispositivo. Se acabó el envío de datos confidenciales a una granja de servidores en no se sabe dónde. Es como tener un asistente personal genial que también es muy bueno guardando secretos.

Músculo del mundo real

Pero, ¿qué pueden hacer realmente estas miniaturas de IA? Resulta que mucho. Ministral 3B y Ministral 8B lo están petando en aplicaciones del mundo real. Estamos hablando de servicios de traducción que funcionan sin Internet, asistentes inteligentes que no necesitan llamar a casa y análisis de datos que mantienen tu información confidencial bajo llave. Mistral AI ha creado la navaja suiza de los modelos de inteligencia artificial.

El futuro es pequeño

Lo que Mistral AI ha hecho con Ministral 3B y Ministral 8B no es sólo impresionante, es ASOMBROSO. Estamos ante el futuro de la IA, y no se trata de construir modelos más grandes, sino más inteligentes. Estas potentes máquinas compactas demuestran que, a veces, lo mejor viene en frasco pequeño.

Impacto en la industria

Las repercusiones de Ministral 3B y Ministral 8B ya se dejan sentir en el mundo de la tecnología. Mistral AI ha lanzado el guante a los grandes: el tamaño no lo es todo. Estamos viendo cómo desarrolladores y empresas se pelean por hacerse con estos modelos, y las aplicaciones que se les ocurren son alucinantes.

Desde robots autónomos hasta dispositivos domésticos inteligentes, Ministral 3B y Ministral 8B se están abriendo camino en todo. Mistral AI ha creado modelos que pueden impulsar la próxima generación de aplicaciones de IA sin necesidad de un superordenador. Estamos hablando de IA que puede funcionar en tu smartphone, smartwatch o incluso en tu nevera.

El camino por recorrer

¿Cuál es el futuro de Mistral AI y su dúo dinámico? La empresa ya insinúa versiones especializadas de Ministral 3B y Ministral 8B para sectores específicos. Imagínese modelos personalizados para la sanidad, las finanzas o la educación: las posibilidades son infinitas.

Descripciones

- Parámetros: Las unidades básicas de conocimiento en los modelos de IA. Piense en ellos como si fueran células cerebrales: más no siempre significa más inteligente.

- Arquitectura de transformador denso: Una forma compacta de construir modelos de IA, como diseñar una casa diminuta en la que cada centímetro de espacio se utiliza de forma eficiente.

- Token: Un fragmento de texto que la IA puede entender. Puede ser una palabra, parte de una palabra o incluso un signo de puntuación.

- Ventana de contexto: La cantidad de información que la IA puede tener en cuenta a la vez, como cuántas páginas de un libro puedes retener en tu mente mientras lees.

- Patrón de atención de ventana deslizante: Una técnica en la que la IA mira la información por trozos, como si leyera un libro a través de una lupa en movimiento.

- Edge computing: Ejecución de software en dispositivos locales (teléfonos, portátiles) en lugar de enviar datos a servidores remotos.

- Ajuste: Adaptación de un modelo de IA a tareas específicas, como enseñar a un profesor de conocimientos generales a convertirse en especialista en matemáticas.

Preguntas más frecuentes

- ¿Cómo se compara Ministral 8B con modelos de IA más grandes?

Ministral 8B demuestra que lo grande no siempre es mejor en IA. A pesar de tener sólo 8.000 millones de parámetros, iguala o supera en muchas tareas a modelos que duplican su tamaño. El modelo utiliza una arquitectura eficiente que maximiza la contribución de cada parámetro. Su velocidad y capacidad de procesamiento local lo hacen especialmente práctico para aplicaciones del mundo real. Además, puede procesar grandes cantidades de texto en dispositivos de consumo normales. - ¿Puede Ministral 8B funcionar sin conexión a Internet?

Sí, Ministral 8B se ejecuta completamente en su dispositivo local. Esto significa que lo procesa todo sin conexión, manteniendo la total privacidad de sus datos. El modelo viene con todos los componentes necesarios preinstalados, por lo que no necesita llamar a un servidor. Esto lo hace perfecto para aplicaciones sensibles o para su uso en zonas con poca conectividad a Internet. Es como tener un pequeño cerebro de inteligencia artificial dentro de tu dispositivo. - ¿Qué tipo de hardware necesito para ejecutar Ministral 8B?

Ministral 8B está diseñado para funcionar en dispositivos de consumo estándar, como teléfonos inteligentes y ordenadores portátiles. El modelo utiliza trucos de ingeniería inteligentes para minimizar sus necesidades de recursos. No se necesita hardware especializado en IA ni grandes cantidades de RAM. Esta accesibilidad lo hace especialmente valioso para desarrolladores y empresas que buscan implantar soluciones de IA sin invertir en costosas infraestructuras. - ¿Cómo gestiona Ministral 8B los distintos idiomas?

Ministral 8B incorpora capacidades multilingües gracias a su amplio vocabulario de 131.072 tokens. El modelo puede entender y procesar varios idiomas sin necesidad de versiones separadas para cada uno. Su arquitectura le permite captar con eficacia patrones lingüísticos en distintas estructuras lingüísticas. Esto lo convierte en una herramienta versátil para aplicaciones globales. - ¿Qué diferencia a Ministral 8B de otros pequeños modelos de IA?

Ministral 8B destaca por su combinación única de eficacia y capacidad. Su densa arquitectura de transformadores procesa la información con mayor eficacia que los enfoques tradicionales. El modelo mantiene un alto rendimiento con un bajo consumo de recursos. Su capacidad para funcionar localmente al tiempo que gestiona tareas complejas lo hace único en el espacio de los modelos pequeños.