Last Updated on abril 16, 2024 9:00 am by Laszlo Szabo / NowadAIs | Published on abril 16, 2024 by Laszlo Szabo / NowadAIs

La IA entiende tu casa – Conoce OpenEQA de Meta: Open-Vocabulary Embodied Question Answering Benchmark – Notas clave

- Meta OpenEQA es un benchmark introducido por Meta AI para evaluar la comprensión de la IA de entornos físicos a través de preguntas de vocabulario abierto.

- Su objetivo es mejorar los modelos de visión y lenguaje (VLM) para lograr un rendimiento más cercano al humano.

- Consta de dos tareas: EQA de memoria episódica y EQA activa, que evalúan la recuperación de memoria de la IA y la interacción con el entorno, respectivamente.

- Fundamental para aplicaciones prácticas como la ayuda en las tareas cotidianas a través de dispositivos inteligentes.

- Indica una brecha significativa entre la IA actual y la comprensión espacial humana, lo que subraya la necesidad de nuevos avances.

Introducción

En la búsqueda de la inteligencia general artificial (AGI), Meta AI, empresa de la matriz de Facebook, ha introducido un benchmark llamado Meta OpenEQA. El objetivo de esta prueba es salvar la distancia que separa los actuales modelos de visión y lenguaje (VLM) del rendimiento humano en la comprensión de espacios físicos. La prueba evalúa la capacidad de un agente de inteligencia artificial para comprender su entorno mediante preguntas de vocabulario abierto, allanando así el camino para los avances en la inteligencia artificial.

La necesidad de la IA incorporada

Imaginemos un mundo en el que los agentes de IA actúen como el cerebro de robots domésticos o gafas inteligentes, capaces de aprovechar modalidades sensoriales como la visión para comprender a los humanos y comunicarse con ellos de forma eficaz. Este ambicioso objetivo requiere que los agentes de IA desarrollen una comprensión exhaustiva del mundo exterior, lo que se conoce como “modelo del mundo”

“modelo del mundo”

Meta AI reconoce que alcanzar este nivel de comprensión es un reto de investigación de enormes proporciones, pero esencial para el desarrollo de la AGI.

Los modelos lingüísticos tradicionales han logrado avances significativos en la comprensión lingüística, pero carecen de comprensión en tiempo real del mundo que les rodea. La meta IA pretende mejorar estos modelos incorporando información visual que les permita comprender su entorno y dar respuestas significativas a las preguntas de los usuarios. Combinando la visión y el lenguaje, los agentes de IA incorporados pueden revolucionar diversos ámbitos, desde los hogares inteligentes hasta los wearables.

Presentación de Meta OpenEQA

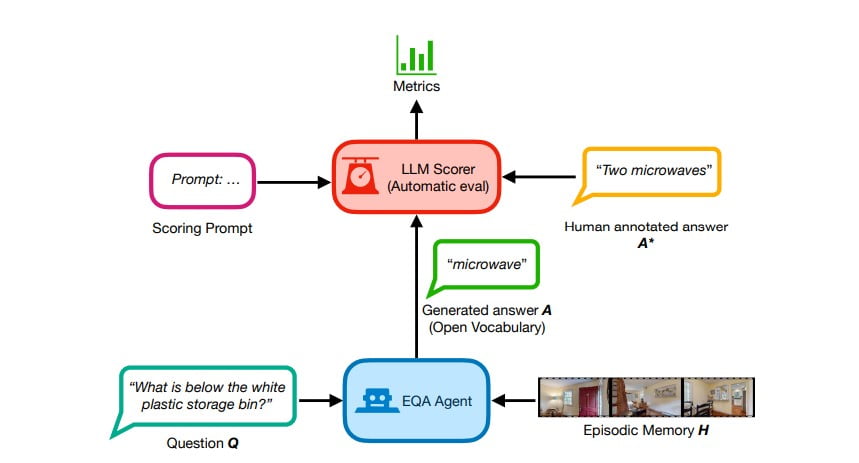

Con el objetivo de hacer avanzar la IA incorporada, Meta AI ha introducido el marco OpenEQA (Open-Vocabulary Embodied Question Answering). Esta referencia mide la comprensión del entorno por parte de un agente de IA sometiéndolo a preguntas de vocabulario abierto. OpenEQA consta de dos tareas: EQA de memoria episódica y EQA activa.

La memoria episódica requiere que el agente responda a preguntas basadas en el recuerdo de experiencias pasadas. Esta tarea pone a prueba la capacidad del agente para recuperar información relevante de su memoria y proporcionar respuestas precisas. Por otro lado, la EQA activa implica que el agente de IA explore activamente su entorno para recopilar la información necesaria y responder a las preguntas. Esta tarea evalúa la capacidad del agente para interactuar con el mundo físico y utilizar su entorno para obtener información.

La importancia del EQA

Embodied Question Answering (EQA) tiene inmensas implicaciones prácticas que van más allá de la investigación. Incluso una versión básica de EQA puede simplificar la vida cotidiana. Imagine, por ejemplo, que se dispone a salir de casa pero no encuentra la tarjeta de la oficina. Con EQA, sólo tiene que preguntar a sus gafas inteligentes o a su robot dónde la ha dejado, y el agente de IA puede aprovechar su memoria episódica para darle la respuesta. EQA tiene el potencial de mejorar las interacciones hombre-máquina y convertir a los agentes de IA en compañeros indispensables en nuestra vida cotidiana.

OpenEQA de Meta no se limita a las aplicaciones prácticas; también sirve como herramienta para sondear la comprensión del mundo por parte de un agente de IA. De forma similar a cómo evaluamos la comprensión humana, OpenEQA evalúa la capacidad de un agente de IA para responder a preguntas de forma precisa y coherente. Con la publicación de este punto de referencia, Meta AI pretende motivar y facilitar la investigación abierta para mejorar las capacidades de comprensión y comunicación de los agentes de IA, un paso crucial hacia la consecución de la AGI.

La brecha entre los VLM y el rendimiento humano

Meta AI llevó a cabo una amplia evaluación comparativa de los modelos de visión y lenguaje (VLM) más avanzados utilizando OpenEQA. Los resultados revelaron una brecha entre el rendimiento de los mejores VLM y la comprensión a nivel humano. En particular, en las preguntas que requieren comprensión espacial, incluso los VLM más avanzados resultaron ser “casi ciegos”

“casi ciegos”

En otras palabras, el acceso a contenidos visuales no mejoró significativamente su rendimiento en comparación con los modelos basados únicamente en el lenguaje.

Por ejemplo, ante la pregunta

“Estoy sentado en el sofá del salón viendo la televisión. ¿Qué habitación está justo detrás de mí?

los modelos hicieron conjeturas aleatorias sin aprovechar la memoria episódica visual, que debería proporcionar una comprensión del espacio. Esto indica que es necesario seguir mejorando las capacidades de percepción y razonamiento de los VLM antes de que los agentes de IA encarnados con estos modelos estén listos para su uso generalizado.

OpenEQA de Meta: Un nuevo punto de referencia para la IA incorporada

OpenEQA de Meta establece un nuevo estándar en la evaluación del rendimiento de los agentes de IA incorporados. Se trata de la primera referencia de vocabulario abierto para EQA, que proporciona a los investigadores un marco completo para medir y seguir los avances en el aprendizaje multimodal y la comprensión de escenas. La referencia incluye más de 1.600 pares de preguntas y respuestas no planificadas, representativas de casos de uso en el mundo real, validadas por anotadores humanos. Además, incluye más de 180 vídeos y escaneos de entornos físicos, lo que permite a los agentes de IA interactuar con escenarios realistas.

Para evaluar las respuestas de vocabulario abierto generadas por los agentes de IA, OpenEQA de Meta introduce LLM-Match, una métrica de evaluación automática. Mediante estudios a ciegas con usuarios, Meta AI ha descubierto que LLM-Match se correlaciona estrechamente con los juicios humanos, lo que demuestra su eficacia como criterio de evaluación. El carácter exhaustivo y la robustez de la métrica de evaluación proporcionan a los investigadores una herramienta fiable para medir el rendimiento de sus modelos e identificar áreas de mejora.

Avance de la IA incorporada con OpenEQA de Meta

OpenEQA de Meta es un desarrollo que allana el camino para los avances en IA incorporada. Al proporcionar un punto de referencia que evalúa la comprensión del entorno por parte de un agente de IA, Meta AI anima a los investigadores a esforzarse por mejorar la comprensión espacial y las capacidades de comunicación efectiva. Al centrarse en preguntas de vocabulario abierto y escenarios del mundo real, la prueba permite a los investigadores desarrollar agentes de IA capaces de navegar e interactuar con el mundo físico de forma similar a los humanos.

Meta AI trabaja activamente en la creación de modelos mundiales capaces de obtener buenos resultados en OpenEQA e invita a investigadores de todo el mundo a unirse a ellos en este empeño. La publicación oficial del benchmark sienta las bases para la investigación colaborativa y la innovación, empujando los límites de la IA y acercándonos a la realización de la inteligencia general artificial.

Definiciones

- Meta: Anteriormente Facebook, Meta es un conglomerado tecnológico conocido por ampliar los límites de las redes sociales, la realidad virtual y la investigación en inteligencia artificial.

- Inteligencia Artificial Generativa: Se refiere a los sistemas de IA que pueden generar textos, imágenes o ideas similares a los humanos basándose en el entrenamiento a partir de grandes conjuntos de datos.

- OpenEQA de Meta: Un sistema de referencia de vocabulario abierto y respuesta a preguntas personificadas desarrollado por Meta AI para evaluar y mejorar la comprensión e interacción de la IA con su entorno físico.

- Modelos de visión y lenguaje (VLM): Sistemas de IA que integran el procesamiento visual con la comprensión del lenguaje para interpretar y responder a entradas multimodales.

- Meta AI: división de Meta dedicada al avance de la tecnología de IA, centrada en la creación de modelos que mejoren la interacción y comprensión entre el ser humano y la IA.

Preguntas más frecuentes

- ¿Qué es OpenEQA de Meta y cómo afecta a la investigación en IA? Meta OpenEQA es una herramienta de referencia diseñada por Meta AI para probar y mejorar la capacidad de los agentes de IA para comprender e interactuar con su entorno físico utilizando preguntas de vocabulario abierto. Constituye un paso crucial hacia el desarrollo de una IA capaz de operar eficazmente en entornos reales.

- ¿Por qué es importante el desarrollo de OpenEQA de Meta para el futuro de los dispositivos inteligentes? Al mejorar la forma en que la IA entiende los entornos espaciales, OpenEQA de Meta allana el camino para agentes de IA más inteligentes e intuitivos en dispositivos como robots y gafas inteligentes, haciendo que la tecnología sea más útil en las tareas cotidianas.

- ¿En qué se diferencia OpenEQA de Meta de las pruebas tradicionales de IA? A diferencia de las pruebas tradicionales, que se centran en la comprensión lingüística o visual, OpenEQA de Meta combina estos elementos para evaluar la comprensión multimodal y la interacción de la IA en un entorno 3D.

- ¿Qué retos aborda OpenEQA de Meta en el campo de la inteligencia artificial? OpenEQA de Meta aborda el reto de crear una IA capaz de comprender el contexto y realizar tareas de forma similar a los humanos, especialmente en la navegación y respuesta a entornos del mundo real.

- ¿Qué futuros avances podemos esperar de OpenEQA de Meta? A medida que OpenEQA de Meta continúe evolucionando, podemos esperar avances que conduzcan a modelos de IA con una mejor conciencia espacial y habilidades de comunicación más eficaces, que son esenciales para el despliegue práctico de la IA en escenarios cotidianos.