Last Updated on Juli 10, 2024 10:56 am by Laszlo Szabo / NowadAIs | Published on Juli 10, 2024 by Laszlo Szabo / NowadAIs

LivePortrait: Von statischen Bildern zu dynamischen Porträtanimationen mit KI – Wichtige Hinweise

- LivePortrait ist ein KI-gesteuertes Framework für Porträtanimationen.

- Entwickelt von Kuaishou Technology, der University of Science and Technology of China und der Fudan University.

- Verwendet ein implizites, tastenpunktbasiertes Framework für Effizienz und Kontrolle.

- Kann Animationen mit 12,8 Millisekunden pro Frame auf einer RTX 4090 GPU erzeugen.

- Trainiert auf 69 Millionen qualitativ hochwertigen Frames für eine verbesserte Generalisierung.

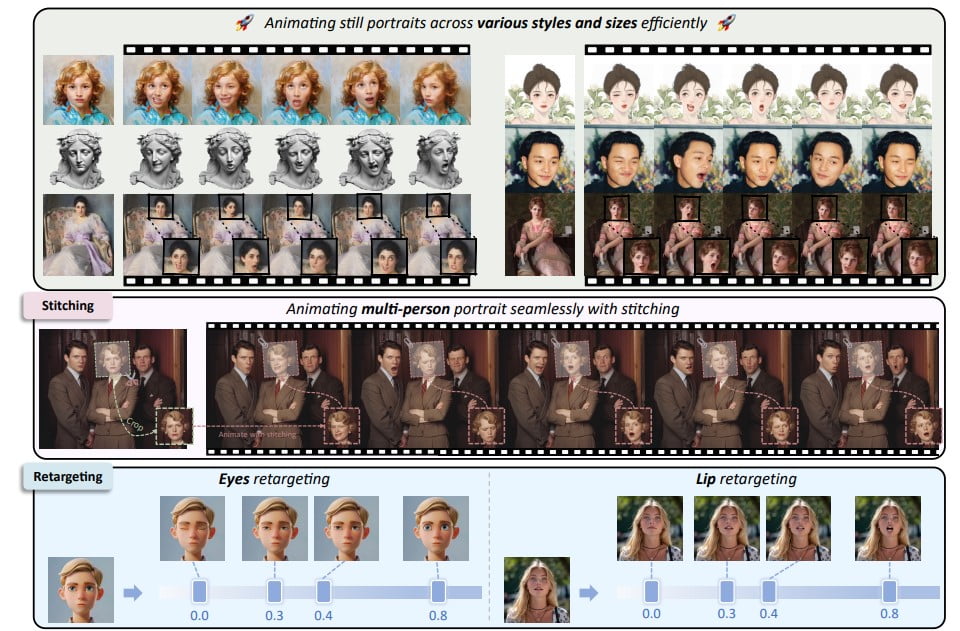

- Bietet Stitching- und Retargeting-Module für verbesserte Kontrolle.

- Kann sowohl Tierporträts als auch menschliche Porträts animieren.

- Konzentriert sich auf ethische Erwägungen, um Missbrauch bei Deep Fakes zu verhindern.

LivePortrait ist verfügbar – Einführung

Die Animation von Porträts ist seit langem ein fesselndes und anspruchsvolles Gebiet im Bereich der Erstellung digitaler Inhalte. Traditionell erforderte die Animation eines statischen Bildes, um es zum Leben zu erwecken, mühsame manuelle Arbeit, komplexe Software und erheblichen Zeitaufwand. Die jüngsten Fortschritte im Bereich der künstlichen Intelligenz (KI) haben dies jedoch wesentlich einfacher, kontrollierbarer und qualitativ hochwertiger gemacht.

Hier kommt LivePortrait ins Spiel, ein neues KI-gesteuertes Porträtanimations-Framework, das von einem Team von Forschern der Kuaishou Technology, der University of Science and Technology of China und der Fudan University entwickelt wurde. Dieses innovative Tool nutzt die Kraft der KI, um statische Porträts in lebensechte, dynamische Bilder zu verwandeln, und bietet eine transformative Lösung für Content-Ersteller, Digitalkünstler und verschiedene praktische Anwendungen.

Implizites, schlüsselpunktbasiertes Framework: Gleichgewicht zwischen Effizienz und Kontrollierbarkeit

Der Kern des LivePortrait-Ansatzes ist die Verwendung eines impliziten, auf Schlüsselpunkten basierenden Rahmens, der sich von den üblichen diffusionsbasierten Methoden unterscheidet. Diese strategische Entscheidung ermöglicht es dem Modell, ein empfindliches Gleichgewicht zwischen Recheneffizienz und granularer Kontrollierbarkeit herzustellen, was es zu einer praktischen und vielseitigen Lösung für reale Szenarien macht.

Im Gegensatz zu herkömmlichen diffusionsbasierten Techniken, die sehr rechenintensiv sein können, sorgt das implizite, auf Keypoints basierende Framework von LivePortrait für schnelle Generierungsgeschwindigkeiten. Das Modell ist in der Lage, Animationen mit beeindruckenden 12,8 Millisekunden pro Frame auf einer RTX 4090 GPU zu erzeugen. Diese Effizienz ist ein entscheidender Faktor, insbesondere bei Anwendungen, bei denen Echtzeitleistung von größter Bedeutung ist, wie z. B. bei Videokonferenzen, sozialen Medien und interaktiver Unterhaltung.

Verbesserte Generalisierung und Generierungsqualität

Um die Fähigkeiten von LivePortrait weiter zu verbessern, haben die Forscher mehrere wichtige Verbesserungen vorgenommen, angefangen bei der Erweiterung des Trainingsdatensatzes. Durch die Vergrößerung der Trainingsdaten auf erstaunliche 69 Millionen qualitativ hochwertige Einzelbilder wurden die Generalisierungsfähigkeiten des Modells erheblich verbessert, so dass es eine breite Palette von Porträtstilen und -szenarien mit gleichbleibender Genauigkeit und Realismus behandeln kann:

“Wir verbessern zunächst eine leistungsstarke, auf impliziten Keypoints basierende Methode [5], indem wir die Trainingsdaten auf etwa 69 Millionen hochwertige Porträtbilder erhöhen, eine gemischte Bild-/Videotrainingsstrategie einführen und die Trainingsdaten auf eine höhere Qualität bringen

eine gemischte Bild-Video-Trainingsstrategie einführen, die Netzwerkarchitektur verbessern, die skalierbare Bewegungstransformation verwenden, die landmark-geführte implizite Keypoint-Optimierung und mehrere kaskadierte Verlustterme entwickeln”

heißt es in ihrem Papier.

Ergänzend zu diesem datengesteuerten Ansatz hat das Team auch eine gemischte Bild-Video-Trainingsstrategie angewandt, die es dem Modell ermöglicht, sowohl aus statischen Bildern als auch aus dynamischen Videobildern zu lernen. Dieser hybride Lernprozess hat zu natürlicheren und flüssigeren Animationen geführt, die das statische Erscheinungsbild des Ausgangsporträts nahtlos mit der ausdrucksstarken Bewegung aus den Fahrdaten verbinden.

Verbesserte Netzwerkarchitektur und kompakte implizite Keypoints

Neben dem umfangreichen Trainingsdatensatz und der gemischten Lernstrategie wurde auch die Architektur des LivePortrait-Frameworks verbessert, um komplexere Bewegungstransformationen und Optimierungsziele zu unterstützen. Diese Verbesserungen haben zur allgemeinen Verbesserung der Animationsqualität beigetragen und gewährleisten, dass die generierten Ergebnisse nicht nur effizient, sondern auch visuell überzeugend sind.

Darüber hinaus haben die Forscher entdeckt, dass kompakte implizite Keypoints eine Art von Blendshapes, ein entscheidendes Element in der Gesichtsanimation, effektiv darstellen können. Durch die Verwendung dieser effizienten Darstellung ist LivePortrait in der Lage, qualitativ hochwertige Animationsergebnisse zu erzielen und gleichzeitig den Rechenaufwand zu minimieren, was bei Echtzeitanwendungen ein entscheidender Faktor ist.

Stitching- und Retargeting-Module: Verbesserte Kontrollierbarkeit

Eines der herausragenden Merkmale von LivePortrait sind die sorgfältig entwickelten Stitching- und Retargeting-Module, die dem Benutzer ein höheres Maß an Kontrolle und Anpassung ermöglichen. Diese Module, die von kleinen MLP-Netzwerken (Multi-Layer Perceptron) angetrieben werden, verursachen nur einen vernachlässigbaren Rechenaufwand und ermöglichen gleichzeitig eine präzise Kontrolle über den Animationsprozess.

Das Stitching-Modul ermöglicht die nahtlose Integration von animierten Gesichtern in die Originalbilder, wodurch die Animation von Ganzkörperporträts und mehreren Gesichtern in einem einzigen Bild möglich ist. Diese Fähigkeit ist besonders wertvoll für Anwendungen, bei denen die Beibehaltung der Integrität der ursprünglichen Bildkomposition wichtig ist.

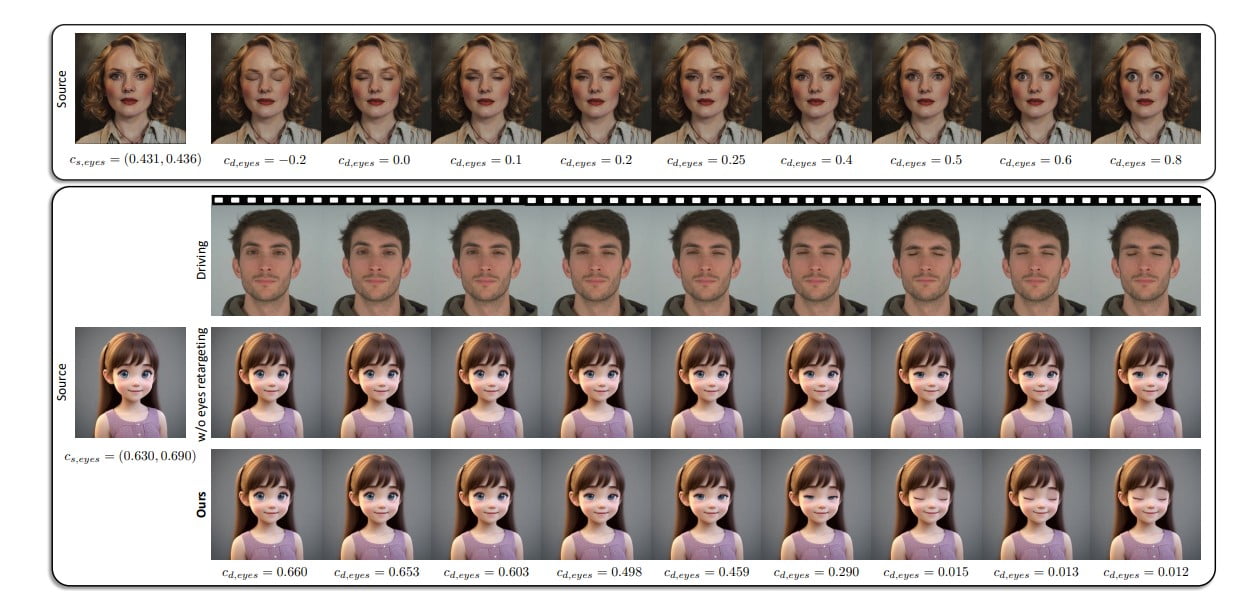

Ergänzend zur Stitching-Funktionalität bieten die Retargeting-Module eine fein abgestimmte Kontrolle über bestimmte Gesichtsmerkmale, wie z. B. Augen- und Lippenbewegungen. Die Benutzer können nun das Ausmaß der Augen- und Lippenöffnung fein abstimmen und so eine neue Ebene der Ausdruckskraft und kreativen Kontrolle im Porträtanimationsprozess erschließen.

Verallgemeinerung auf Tierporträts: Ausweitung der kreativen Möglichkeiten

Die Vielseitigkeit von LivePortrait geht über menschliche Porträts hinaus, denn die Forscher haben bewiesen, dass sich das Programm auch auf Tierporträts übertragen lässt. Durch die Feinabstimmung des Modells auf Tierdaten kann das Framework nun die Gesichter von niedlichen Katzen, Hunden, Pandas und anderen pelzigen Begleitern präzise animieren, was eine Welt der kreativen Möglichkeiten für Inhaltsersteller und digitale Künstler eröffnet.

Diese speziesübergreifende Animationsfunktion erweitert die Anwendungsmöglichkeiten von LivePortrait und ermöglicht es den Anwendern, ihre tierbezogenen Projekte mit demselben Grad an Realismus und Kontrolle zum Leben zu erwecken wie ihre menschlichen Porträtanimationen.

Experimentelle Validierung und Benchmarking

Die Effektivität des LivePortrait-Frameworks wurde durch umfangreiche Experimente und Benchmarking gründlich evaluiert. Vergleichende Analysen haben gezeigt, dass das Modell sowohl diffusionsbasierte als auch nicht-diffusionsbasierte Methoden bei Standardmetriken für Porträtanimationsqualität und Bewegungsgenauigkeit übertrifft.

Die Stitching- und Retargeting-Module haben ihre Fähigkeit unter Beweis gestellt, animierte Gesichter nahtlos in Originalbilder zu integrieren und eine fein abgestimmte Kontrolle über Augen- und Mundbewegungen zu bieten, was die Position von LivePortrait als Spitzenlösung im Bereich der Porträtanimation weiter festigt.

Praktische Anwendungen und ethische Erwägungen

Die potenziellen Anwendungsmöglichkeiten von LivePortrait erstrecken sich über ein breites Spektrum von Branchen, von Videokonferenzen und sozialen Medien bis hin zu Unterhaltung und der Produktion kreativer Inhalte. Durch die effiziente und kontrollierbare Animation von statischen Porträts kann dieses Framework die Art und Weise, wie digitale Inhalte erstellt und konsumiert werden, revolutionieren.

Die Forscher, die hinter LivePortrait stehen, sind sich jedoch auch der potenziellen ethischen Bedenken bewusst, die mit dem Missbrauch solch fortschrittlicher Technologien einhergehen, insbesondere im Bereich der Fälschungen. Um diese Risiken zu mindern, haben sie vorgeschlagen, dass die visuellen Artefakte in den aktuellen Ergebnissen als Abschreckung dienen könnten, die bei der Erkennung manipulierter Inhalte helfen.

Beschränkungen und zukünftige Entwicklungen

Obwohl LivePortrait einen bedeutenden Fortschritt in der Porträtanimation darstellt, räumen die Forscher ein, dass es noch Raum für Verbesserungen gibt. Eine der derzeitigen Einschränkungen ist die Fähigkeit des Modells, mit großen Posenvariationen umzugehen, ein Bereich, der weiter erforscht und verfeinert werden muss.

Da sich der Bereich der KI-gesteuerten Porträtanimation ständig weiterentwickelt, setzt das LivePortrait-Team auf kontinuierliche Forschung und Entwicklung und erforscht neue Techniken und Architekturen, um die Fähigkeiten des Frameworks zu verbessern. Das Ziel ist es, die Grenzen des Möglichen in diesem dynamischen und sich schnell entwickelnden Bereich zu erweitern, um Kreative zu unterstützen und Innovationen voranzutreiben.

Schlussfolgerung: Die Zukunft der Porträtanimation erschließen

LivePortrait ist ein Beweis für die transformative Kraft der KI-gesteuerten Innovationim Bereich der Porträtanimation. Durch die Ausgewogenheit zwischen Recheneffizienz und granularer Kontrolle hat das Framework die Möglichkeiten, statische Bilder zum Leben zu erwecken, neu definiert und erfüllt damit die unterschiedlichen Bedürfnisse von Content-Erstellern, Digitalkünstlern und verschiedenen praktischen Anwendungen.

Mit der Weiterentwicklung der Technologie ist das Potenzial für noch fesselndere und ausdrucksstärkere animierte Porträts grenzenlos und ebnet den Weg für eine Zukunft, in der die Grenzen zwischen Statik und Dynamik nahtlos verwischt werden.

Definitionen

- LivePortrait: Ein KI-gesteuertes Framework, das statische Porträts zu dynamischen, lebensechten Bildern animiert.

- Kuaishou-Technologie: Ein chinesisches Technologieunternehmen, das für seine beliebte Video-Sharing-App, Kuaishou, bekannt ist.

- Universität für Wissenschaft und Technologie von China: Eine angesehene Forschungsuniversität in China, die auf Wissenschaft und Technik spezialisiert ist.

- Fudan-Universität: Eine der renommiertesten Universitäten Chinas mit Sitz in Shanghai, bekannt für ihre Forschung in verschiedenen wissenschaftlichen Bereichen.

- TX 4090-GPU: Ein Hochleistungs-Grafikprozessor von NVIDIA, der für rechenintensive Aufgaben wie KI und Rendering verwendet wird.

- Videobild: Ein einzelnes Bild oder ein Schnappschuss in einer Sequenz, aus der ein Video besteht.

- Mehrschichtige Perzeptron-Netzwerke (MLP): Eine Art künstliches neuronales Netzwerk, das für Aufgaben des maschinellen Lernens verwendet wird und aus mehreren Schichten von Knoten besteht.

- Deep Fakes: Von künstlicher Intelligenz (KI) erzeugte synthetische Medien, bei denen das Abbild einer Person in Videos oder Bildern durch das einer anderen Person ersetzt wird, was häufig in böser Absicht geschieht.

Häufig gestellte Fragen

1. Was ist LivePortrait? LivePortrait ist ein KI-gesteuertes Framework, das statische Porträts zu dynamischen, lebensechten Bildern animiert. Es wurde von einem Team von Forschern der Kuaishou Technology, der University of Science and Technology of China und der Fudan University entwickelt und nutzt fortschrittliche KI zur Erstellung realistischer Animationen.

2. Wie funktioniert LivePortrait? LivePortrait verwendet ein implizites, tastenpunktbasiertes Framework, das Effizienz und Kontrolle in Einklang bringt. Dadurch kann das Modell Animationen mit einer Geschwindigkeit von 12,8 Millisekunden pro Frame auf einer RTX 4090 GPU erzeugen und eignet sich somit für Echtzeitanwendungen wie Videokonferenzen und soziale Medien.

3. Was sind die wichtigsten Merkmale von LivePortrait? LivePortrait verfügt über einen großen Trainingsdatensatz mit 69 Millionen qualitativ hochwertigen Frames, Stitching- und Retargeting-Module für verbesserte Kontrolle und die Möglichkeit, sowohl menschliche als auch tierische Porträts zu animieren. Die Software bietet eine präzise Kontrolle über die Gesichtszüge und integriert animierte Gesichter nahtlos in die Originalbilder.

4. Kann LivePortrait für die Erstellung von Fälschungen verwendet werden? Obwohl LivePortrait über fortschrittliche Funktionen verfügt, sind sich die Forscher des Missbrauchspotenzials bei der Erstellung von Fälschungen bewusst. Sie haben vorgeschlagen, dass visuelle Artefakte in den aktuellen Ergebnissen bei der Erkennung manipulierter Inhalte helfen könnten, um eine unethische Nutzung zu verhindern.

5. Welche Anwendungsmöglichkeiten hat LivePortrait? LivePortrait kann in verschiedenen Bereichen wie Videokonferenzen, sozialen Medien, Unterhaltung und der Produktion kreativer Inhalte eingesetzt werden. Es bietet eine effiziente und kontrollierbare Möglichkeit, statische Porträts zu animieren und revolutioniert damit die Erstellung digitaler Inhalte.