Last Updated on August 26, 2024 12:46 pm by Laszlo Szabo / NowadAIs | Published on August 26, 2024 by Laszlo Szabo / NowadAIs

Jamba 1.5: AI21’s hybride KI 2,5x schneller als alle führenden Mitbewerber – Wichtige Hinweise

- Jamba 1.5 kombiniert die Architekturen von Transformer und Mamba und bietet damit eine verbesserte Leistung und Effizienz.

- Das Modell bewältigt Szenarien mit langen Kontexten mit einem Kontextfenster von 256.000 Token und bietet dabei höchste Leistung.

- Durch die Mehrsprachigkeit von Jamba 1.5 ist es in mehreren Sprachen einsetzbar, darunter Spanisch, Französisch und Deutsch.

- Das Modell führt die ExpertsInt8-Quantisierungstechnik ein, die einen groß angelegten Einsatz auf minimaler Hardware ermöglicht.

Einführung

Jamba 1.5 ist ein hybrides KI-Wunder, das die Stärken der Transformer- und Mamba-Architekturen nahtlos miteinander verbindet und so eine unvergleichliche Leistung, Effizienz und Vielseitigkeit bietet. Entwickelt von den visionären Köpfen bei AI21, verändert diese bahnbrechende Technologie die Möglichkeiten im Bereich der Verarbeitung natürlicher Sprache.

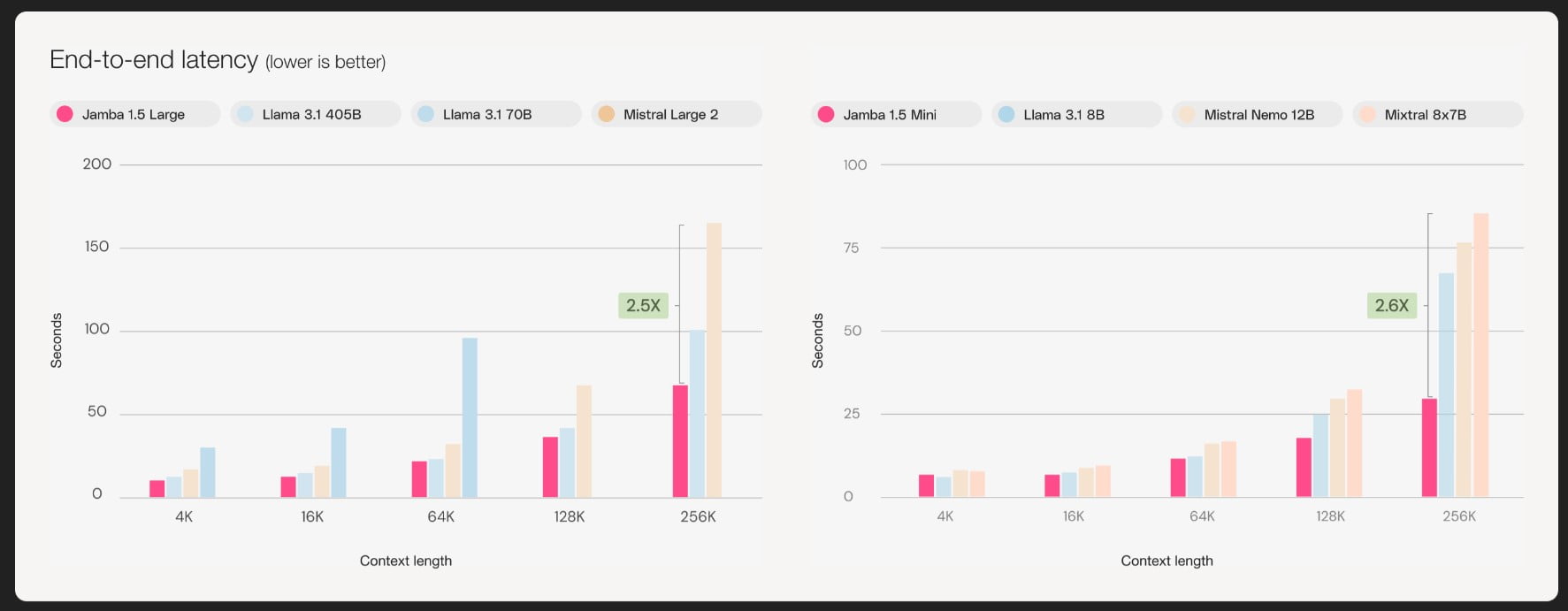

Der Vorteil von Jamba 1.5: Ein hybrides Kraftpaket

Im Mittelpunkt von Jamba 1.5 steht ein neuartiger Ansatz, der das Beste aus beiden Welten vereint – die robuste Transformer-Architektur und das innovative Mamba-Framework. Diese synergetische Verschmelzung führt zu einem Hybridmodell, das nicht nur bei der Verarbeitung von Szenarien mit langem Kontext überragend ist, sondern auch mit bemerkenswerter Geschwindigkeit und Effizienz aufwarten kann und seine Konkurrenten um das 2,5-fache übertrifft.

Unerreichte Fähigkeiten zur Handhabung von Kontexten

Eines der herausragenden Merkmale von Jamba 1.5 ist seine Fähigkeit, nahtlos durch umfangreiche Kontextinformationen zu navigieren und diese zu verarbeiten. Mit einem noch nie dagewesenen Kontextfenster von 256.000 Token ermöglicht dieses KI-Wunder den Anwendern, komplizierte Erzählungen, komplexe Datensätze und umfangreiche Dokumente mit unübertroffener Präzision und Klarheit zu erfassen und zu verstehen.

Optimiert für Geschwindigkeit und Effizienz

Jamba 1.5 ist nicht nur ein Kraftpaket in Sachen Leistung, sondern auch ein Wegbereiter in Sachen Geschwindigkeit und Effizienz. Dank seiner hochmodernen Architektur liefert dieses Modell blitzschnelle Inferenzzeiten, was es zur idealen Wahl für zeitkritische Anwendungen und Echtzeit-Interaktionen macht.

Ein vielseitiger Werkzeugkasten für vielfältige Anwendungen

Ganz gleich, ob Sie den Kundenservice verbessern, Geschäftsprozesse rationalisieren oder neue Wege in Forschung und Entwicklung beschreiten möchten, Jamba 1.5 bietet eine vielseitige Toolbox, die auf Ihre individuellen Bedürfnisse zugeschnitten ist. Mit Funktionen, die vom Funktionsaufruf und der Generierung strukturierter Ausgaben bis hin zur Generierung von Grundlagen und Sprachverständnis reichen, können Sie mit dieser KI eine Vielzahl von Herausforderungen mit beispielloser Präzision und Anpassungsfähigkeit bewältigen.

Mehrsprachige Fähigkeiten: Überwindung von Sprachbarrieren

Jamba 1.5 ist nicht nur ein Sprachvirtuose in Englisch, sondern beherrscht auch eine Vielzahl von Sprachen, darunter Spanisch, Französisch, Portugiesisch, Italienisch, Niederländisch, Deutsch, Arabisch und Hebräisch. Diese Mehrsprachigkeit eröffnet neue Wege für die kulturübergreifende Kommunikation und ermöglicht es Unternehmen und Organisationen, mit unterschiedlichen Zielgruppen auf globaler Ebene in Kontakt zu treten.

Benchmarking-Exzellenz

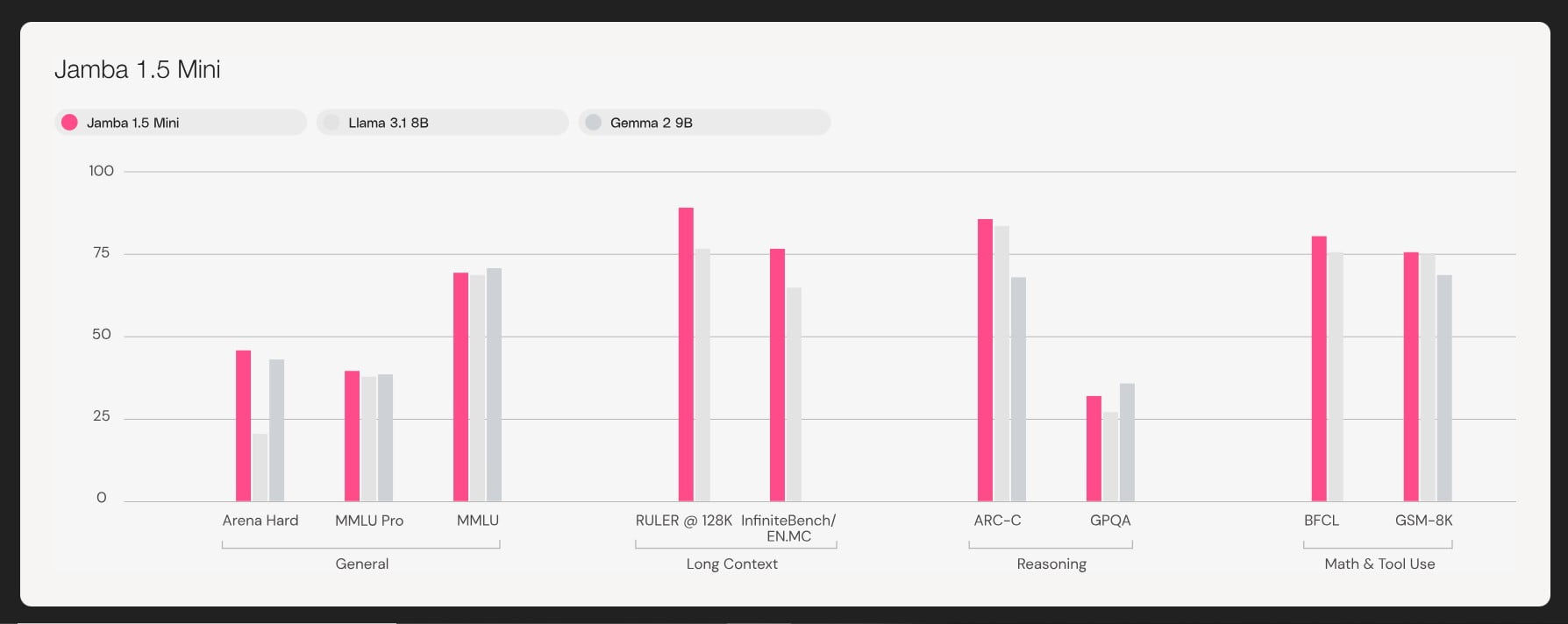

Wenn es um Leistungsbenchmarks geht, legt Jamba 1.5 die Messlatte hoch und übertrifft seine Konkurrenten in einer Vielzahl von Standardtests. Ob bei anspruchsvollen Aufgaben wie Arena Hard und Wild Bench oder mit erstklassigen Ergebnissen bei Sprachverständnis-Benchmarks wie MMLU und GPQA – dieses KI-Modell stellt sein Können immer wieder unter Beweis.

Effektive Kontextlänge: Aufrechterhaltung der Spitzenleistung

Einer der bemerkenswertesten Aspekte von Jamba 1.5 ist seine Fähigkeit, die Spitzenleistung über die gesamte Dauer des umfangreichen Kontextfensters aufrechtzuerhalten. Im Gegensatz zu vielen anderen Modellen, die mit zunehmender Kontextlänge an Effektivität einbüßen, liefert Jamba 1.5 durchgängig zuverlässige und genaue Ergebnisse, selbst bei den komplexesten und umfangreichsten Eingaben.

Innovation bei der Quantisierung

Um die Fähigkeiten und die Zugänglichkeit von Jamba 1.5 weiter zu verbessern, hat AI21 eine Quantisierungstechnik namens ExpertsInt8 eingeführt. Dieser innovative Ansatz ermöglicht es, Jamba 1.5 Large, die größere Variante der Modellfamilie, auf einer einzigen Maschine mit nur acht 80GB GPUs einzusetzen, ohne Kompromisse bei der Qualität oder Leistung einzugehen. Diese Leistung erweitert nicht nur die Reichweite des Modells, sondern ebnet auch den Weg für effizientere und kostengünstigere Implementierungen.

Nahtlose Integration: Vielfältige Bereitstellungsoptionen

Ganz gleich, ob Sie eine Cloud-basierte Lösung suchen oder eine Bereitstellung vor Ort bevorzugen, Jamba 1.5 bietet eine Reihe von Optionen, die Ihren individuellen Anforderungen entsprechen. Von der produktionsreifen SaaS-Plattform von AI21 über strategische Partnerschaften mit Branchenführern bis hin zu kundenspezifischen VPC- und On-Premises-Implementierungen – dieses KI-Wunder sorgt für eine nahtlose Integration in Ihre bestehende Infrastruktur.

Unternehmen stärken: Maßgeschneiderte Lösungen

Für Unternehmen mit individuellen und maßgeschneiderten Anforderungen geht AI21 noch einen Schritt weiter und bietet praktisches Management, kontinuierliches Pre-Training und Feinabstimmung. Dieser individuelle Ansatz stellt sicher, dass Jamba 1.5 auf die spezifischen Bedürfnisse Ihres Unternehmens zugeschnitten werden kann und neue Dimensionen der Produktivität und Innovation eröffnet.

Entfesselte Kreativität: Tools für Entwickler

Jamba 1.5 ist nicht nur ein Kraftpaket für Unternehmen, sondern auch eine Fundgrube für Entwickler und Kreative. Mit integrierten Funktionen wie Funktionsaufrufe, Ausgabe im JSON-Modus, Dokumentobjekte und Zitiermodus ermöglicht dieses KI-Modell Entwicklern, ihrer Kreativität freien Lauf zu lassen und Anwendungen zu erstellen.

Ethische und verantwortungsbewusste KI: Ein Bekenntnis zur Exzellenz

Das Herzstück der Entwicklung von Jamba 1.5 ist das unerschütterliche Engagement für ethische und verantwortungsvolle KI-Praktiken. AI21 hat große Anstrengungen unternommen, um sicherzustellen, dass dieses Modell die höchsten Standards in Bezug auf Transparenz, Datenschutz und Sicherheit erfüllt und so das Vertrauen von Nutzern und Stakeholdern gleichermaßen stärkt.

Die Zukunft der KI: Umarmung von Jamba 1.5

Jamba 1.5 ist ein Leuchtturm der Innovation und des Fortschritts, da die Welt das transformative Potenzial der künstlichen Intelligenz immer mehr zu schätzen weiß. Mit seinen unvergleichlichen Fähigkeiten, seiner unübertroffenen Effizienz und seinem unermüdlichen Engagement für Spitzenleistungen ist dieses erstaunliche KI-Modell bereit, die Zukunft der Verarbeitung natürlicher Sprache und darüber hinaus zu gestalten. Nutzen Sie die Leistung von Jamba 1.5 und erschließen Sie sich eine Welt voller Möglichkeiten!

Beschreibungen

- Hybrides KI-Modell: Eine Kombination aus verschiedenen KI-Architekturen, um die Stärken jeder einzelnen zu nutzen. Jamba 1.5 integriert die Frameworks Transformer und Mamba, um die Verarbeitungsleistung und Effizienz zu steigern.

- Kontext-Fenster: Die Textmenge, die die KI auf einmal verarbeiten kann. Jamba 1.5 hat ein Kontextfenster von 256.000 Token, d. h. es kann sehr lange Texte verarbeiten, ohne an Genauigkeit zu verlieren.

- Quantisierung (ExpertenInt8): Eine Technik zur Reduzierung der Größe und Komplexität eines KI-Modells ohne Leistungseinbußen. Dadurch kann Jamba 1.5 Large auf weniger GPUs betrieben werden und ist somit besser zugänglich.

- Funktionsaufrufe: Eine Funktion, die es der KI ermöglicht, bestimmte Funktionen oder Aufgaben auf der Grundlage von Benutzereingaben auszuführen. Jamba 1.5 enthält diese Funktion, um interaktivere und dynamischere Ausgaben zu ermöglichen.

- Grundlegende Generierung: Die Fähigkeit der KI, Text auf der Grundlage spezifischer, realer Daten oder Quellen zu generieren, was genauere und zuverlässigere Informationen gewährleistet.

- Vor-Ort-Bereitstellung: Ein Setup, bei dem KI-Modelle auf den physischen Servern innerhalb eines Unternehmens ausgeführt werden, was eine bessere Kontrolle über Daten und Abläufe ermöglicht. Jamba 1.5 unterstützt dies neben Cloud-basierten Lösungen.

Häufig gestellte Fragen

- Was ist Jamba 1.5, und wie unterscheidet es sich von früheren Modellen?

Jamba 1.5 ist ein hybrides KI-Modell, das die Architekturen Transformer und Mamba kombiniert. Es zeichnet sich durch die Verarbeitung umfangreicher Kontexte aus und bietet im Vergleich zu früheren Modellen eine höhere Geschwindigkeit und Effizienz. - Wie bewältigt Jamba 1.5 Szenarien mit langen Kontexten?

Mit einem Kontextfenster von 256.000 Token kann Jamba 1.5 große Textmengen mit hoher Genauigkeit verarbeiten und ist damit ideal für komplexe Erzählungen und lange Dokumente. - Welche Sprachen werden von Jamba 1.5 unterstützt?

Jamba 1.5 ist mehrsprachig und beherrscht Sprachen wie Spanisch, Französisch, Deutsch und andere, so dass es in verschiedenen sprachlichen Umgebungen gut funktioniert. - Was ist die ExpertsInt8-Quantisierung in Jamba 1.5?

ExpertsInt8 ist eine Quantisierungstechnik, die den Ressourcenbedarf des Modells reduziert. Dadurch kann Jamba 1.5 Large auf nur acht 80-GB-GPUs ausgeführt werden, was es kostengünstiger macht. - Kann Jamba 1.5 vor Ort implementiert werden?

Ja, Jamba 1.5 kann sowohl in der Cloud als auch vor Ort eingesetzt werden und bietet somit Flexibilität je nach den Bedürfnissen und der Infrastruktur des Unternehmens.