Last Updated on Mai 24, 2024 1:32 pm by Laszlo Szabo / NowadAIs | Published on Mai 24, 2024 by Laszlo Szabo / NowadAIs

Die Aya-23-Modelle von Cohere: LLM in 23 Sprachen – Wichtige Hinweise

- Aya-23 Modelle: Neueste mehrsprachige Großsprachenmodelle von Cohere For AI.

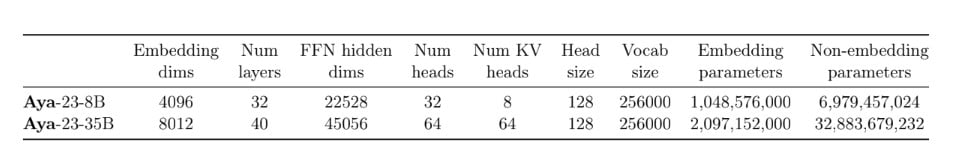

- 8B und 35B Parameter: Zwei Versionen für unterschiedliche Berechnungsmöglichkeiten.

- Mehrsprachiges Ökosystem: Basiert auf der Aya-Sammlung, die 114 Sprachen abdeckt.

- Leistung: Erhebliche Verbesserungen gegenüber früheren Modellen wie Aya-101.

- Open Weights Release: Modelle stehen für Forschung und Entwicklung zur Verfügung.

- Globale Kollaboration: Über 3000 Forscher aus 119 Ländern haben mitgewirkt.

- Linguistische Fähigkeiten: Überlegene Leistung bei Aufgaben wie Zusammenfassung, Übersetzung und Verständnis.

Einführung

In der sich schnell entwickelnden Landschaft der Verarbeitung natürlicher Sprache (NLP) ist die Fähigkeit, verschiedene Sprachen effektiv zu verarbeiten, zu einer entscheidenden Grenze geworden. Herkömmliche NLP-Modelle haben oft Schwierigkeiten, die Nuancen und die Komplexität der mehrsprachigen Kommunikation zu berücksichtigen, was ihre breite Anwendung behindert. Die Pionierarbeit von Cohere For AI hat jedoch eine neue Lösung hervorgebracht – die Aya-23-Familie von mehrsprachigen Sprachmodellen.

Aya-23: Die Überbrückung der mehrsprachigen Lücke

Heute stellen wir Aya 23 vor, eine hochmoderne mehrsprachige 8B- und 35B-Version mit offenen Gewichten.

Aya 23 kombiniert ein hochleistungsfähiges, vortrainiertes Modell mit dem aktuellen Aya-Datensatz und macht mehrsprachige generative KI-Durchbrüche für die Forschungsgemeinschaft zugänglich.🌍https://t.co/9HsmypAbBb pic.twitter.com/TqHlNfh6zf

– Cohere For AI (@CohereForAI) May 23, 2024

Cohere For AI, der gemeinnützige Forschungszweig des kanadischen KI-Startups Cohere, hat die Aya-23-Modelle vorgestellt – eine innovative Reihe mehrsprachiger großer Sprachmodelle (LLMs), die den Bereich der NLP revolutionieren werden. Aya-23 baut auf dem Erfolg des Vorgängermodells Aya-101 auf, das beeindruckende 101 Sprachen abdeckte, allerdings mit einer strategischen Verlagerung des Schwerpunkts.

Aya-23-8B: Effizienz und Zugänglichkeit

Das Modell Aya-23-8B mit 8 Milliarden Parametern wurde entwickelt, um ein Gleichgewicht zwischen Leistung und Zugänglichkeit herzustellen. Durch die Optimierung der Modellarchitektur und die Nutzung fortschrittlicher Techniken wie gruppierte Abfrageaufmerksamkeit und rotierende Positionseinbettungen bietet das Aya-23-8B mehrsprachige Fähigkeiten auf dem neuesten Stand der Technik, ohne dass dafür umfangreiche Rechenressourcen benötigt werden. Dies macht es zu einer idealen Wahl für Forscher und Entwickler, die mit bescheideneren Hardwarekonfigurationen arbeiten.

Aya-23-35B: Unerreichte sprachliche Fähigkeiten

Für diejenigen, die über die nötige Rechenleistung verfügen, um das volle Potenzial auszuschöpfen, bietet das Modell Aya-23-35B mit seinen beeindruckenden 35 Milliarden Parametern unvergleichliche linguistische Fähigkeiten. Aufbauend auf der Grundlage des Command R-Modells von Cohere enthält das Aya-23-35B eine Reihe von Verbesserungen, die seine Leistung bei komplexen mehrsprachigen Aufgaben wie dem Verstehen natürlicher Sprache, der Zusammenfassung und der Übersetzung steigern.

Aya’s mehrsprachiges Ökosystem

Die Aya-23-Modelle sind keine eigenständigen Errungenschaften; sie sind der Höhepunkt der umfassenderen Aya-Initiative von Cohere For AI – einer gemeinsamen Anstrengung, an der über 3.000 unabhängige Forscher aus 119 Ländern beteiligt sind. Diese globale Initiative hat ein reichhaltiges Ökosystem von Ressourcen hervorgebracht, darunter die Aya-Sammlung, ein riesiger mehrsprachiger Datensatz mit 513 Millionen Eingabeaufforderungen und Vervollständigungen in 114 Sprachen.

Die Aya-Sammlung: Förderung des mehrsprachigen Fortschritts

Die Aya-Sammlung dient als Grundlage für die Aya-23-Modelle und bietet einen vielfältigen und hochwertigen Trainingsdatensatz, der es den Modellen ermöglicht, in einer Vielzahl von Sprachen zu brillieren. Durch die Nutzung dieser umfangreichen Ressource zeigen die Aya-23-Modelle eine überlegene Leistung im Vergleich zu anderen weit verbreiteten mehrsprachigen Modellen wie Gemma, Mistral und Mixtral.

Aya-101: Schaffung der Grundlagen

Während die Aya-23-Modelle die neueste Iteration der mehrsprachigen Bemühungen von Cohere For AI darstellen, sollte das bahnbrechende Aya-101-Modell nicht übersehen werden. Aya-101, das im Februar 2024 veröffentlicht wurde, war eine Pionierleistung für sich. Es deckte noch nie dagewesene 101 Sprachen ab und setzte neue Maßstäbe in der massiven mehrsprachigen Sprachmodellierung.

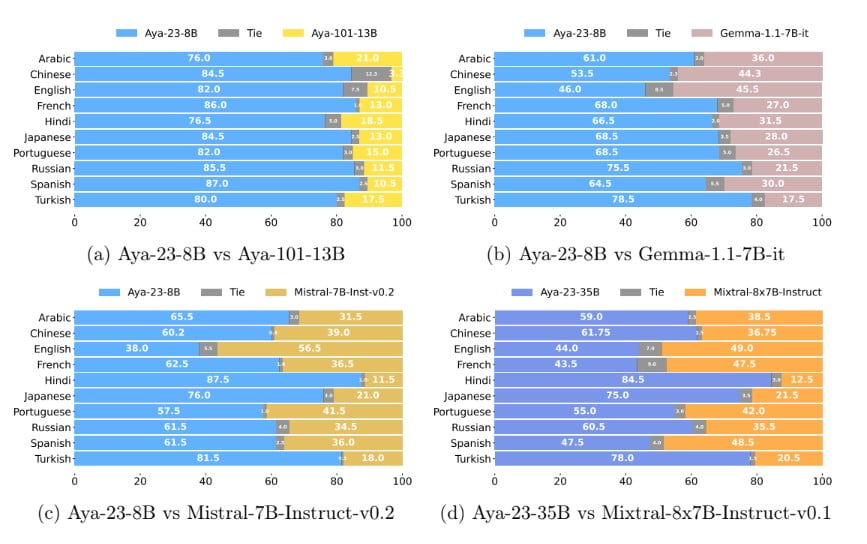

Die Leistungsvorteile von Aya-23

Die Aya-23-Modelle wurden einer strengen Prüfung unterzogen, bei der ihre bemerkenswerten Fähigkeiten bei mehrsprachigen Aufgaben unter Beweis gestellt wurden. Im Vergleich zum Vorgängermodell Aya-101 zeigen die Aya-23-Modelle signifikante Verbesserungen bei einer Reihe von diskriminativen und generativen Aufgaben, wobei die Version mit 8 Milliarden Parametern die beste mehrsprachige Leistung in ihrer Klasse erzielt.

Mehr Leistung als die Konkurrenz

Im Vergleich mit anderen weit verbreiteten Open-Source-Modellen wie Gemma, Mistral und Mixtral schneiden die Aya-23-Modelle durchweg besser ab als ihre Konkurrenten. Die Forscher berichten von Verbesserungen von bis zu 14% bei diskriminierenden Aufgaben, 20% bei generativen Aufgaben und einer bemerkenswerten Steigerung von 41,6% beim mehrsprachigen mathematischen Denken im Vergleich zu Aya-101.

Konsistente Qualität über alle Sprachen hinweg

Eines der herausragenden Merkmale der Aya-23-Modelle ist ihre Fähigkeit, ein hohes Maß an Konsistenz und Kohärenz in dem von ihnen generierten Text zu wahren, unabhängig von der Zielsprache. Dies ist ein entscheidender Vorteil für Anwendungen, die eine nahtlose mehrsprachige Unterstützung erfordern, wie z. B. Übersetzungsdienste, Inhaltserstellung und Gesprächsagenten.

Zugänglichkeit und Open-Source-Engagement

Das Engagement von Cohere For AI für die Förderung der mehrsprachigen KI-Forschung geht über die technischen Errungenschaften der Aya-23-Modelle hinaus. Das Unternehmen hat sich intensiv darum bemüht sicherzustellen, dass diese leistungsstarken Werkzeuge einem breiten Spektrum von Forschern und Entwicklern zugänglich sind.

Open Weights Veröffentlichung

Cohere For AI hat die offenen Gewichte für die beiden Modelle Aya-23-8B und Aya-23-35B veröffentlicht, um der Forschungsgemeinschaft die Möglichkeit zu geben, diese hochmodernen mehrsprachigen Modelle weiter zu erforschen, zu verfeinern und darauf aufzubauen. Dieser Open-Source-Ansatz steht im Einklang mit der Mission des Unternehmens, den Zugang zu hochmoderner KI-Technologie zu demokratisieren.

Ermächtigung der Forschungsgemeinschaft

Durch die Bereitstellung der offenen Gewichte will Cohere For AI Forscher und Praktiker dazu inspirieren und befähigen, die Grenzen der mehrsprachigen KI zu erweitern. Diese Geste erleichtert nicht nur die Weiterentwicklung des Fachgebiets, sondern fördert auch den Geist der Zusammenarbeit, in dem die globale Forschungsgemeinschaft gemeinsam an der Bewältigung der Herausforderungen durch Sprachbarrieren in der Technologie arbeiten kann.

Die Aya-Initiative: Ein Paradigmenwechsel in der mehrsprachigen KI

Die Aya-23-Modelle sind nicht nur das neueste Produkt der Forschungsbemühungen von Cohere For AI, sondern auch Teil einer umfassenderen Initiative, die die Landschaft der mehrsprachigen KI umgestaltet. Das Aya-Projekt, an dem sich über 3.000 unabhängige Forscher aus 119 Ländern beteiligt haben, stellt einen Paradigmenwechsel in der Art und Weise dar, wie die Gemeinschaft des maschinellen Lernens die Herausforderungen der mehrsprachigen Sprachmodellierung angeht.

Demokratisierung der mehrsprachigen KI

Durch die Nutzung der unterschiedlichen Perspektiven und Fachkenntnisse von Forschern aus der ganzen Welt hat die Aya-Initiative einen reichhaltigen Fundus an Wissen und Ressourcen geschaffen, der nun einer breiteren Gemeinschaft zugänglich ist. Dieser kollaborative Ansatz hat die Entwicklung von Modellen wie Aya-23 ermöglicht, die den sprachlichen Bedürfnissen von fast der Hälfte der Weltbevölkerung gerecht werden.

Stärkung der unterversorgten Sprachen

“In unserer Bewertung konzentrieren wir uns auf 23 Sprachen, die von der neuen Aya-Modellfamilie abgedeckt werden. Diese 23 Sprachen sind: Arabisch, Chinesisch (vereinfacht und traditionell), Tschechisch, Niederländisch, Englisch, Französisch, Deutsch, Griechisch, Hebräisch, Hindi, Indonesisch, Italienisch, Japanisch, Koreanisch, Persisch, Polnisch, Portugiesisch, Rumänisch, Russisch, Spanisch, Türkisch, Ukrainisch und Vietnamesisch.”

können Sie in Cohere’s paper lesen .

Einer der wichtigsten Beweggründe für die Aya-Initiative ist die Erkenntnis, dass der Bereich der künstlichen Intelligenz in der Vergangenheit von einer Handvoll Sprachen dominiert wurde, während viele andere Sprachen unterrepräsentiert und unterversorgt waren. Die Aya-23-Modelle mit ihrer Unterstützung für 23 Sprachen, darunter auch seltene und ressourcenarme Sprachen, sind ein wichtiger Schritt, um dieses Ungleichgewicht zu beseitigen und sicherzustellen, dass mehr Sprachen in der sich rasch entwickelnden Welt der generativen KI als Bürger erster Klasse behandelt werden.

Die Zukunft der mehrsprachigen KI: Aya-23 und darüber hinaus

Die Einführung der Aya-23-Modelle ist ein entscheidender Moment auf dem Weg der Forschung und Entwicklung mehrsprachiger KI. Während sich das Feld weiter entwickelt, stehen die Aya-23-Modelle und die breitere Aya-Initiative als Leuchttürme des Fortschritts, die Forscher und Praktiker dazu inspirieren, die Grenzen dessen, was im Bereich der Verarbeitung natürlicher Sprache möglich ist, zu erweitern.

Kontinuierliche Verbesserung vorantreiben

Das Engagement von Cohere For AI für das Aya-Projekt stellt sicher, dass die Reise der mehrsprachigen KI-Fortschritte nicht mit den Aya-23-Modellen endet. Die kontinuierlichen Investitionen des Unternehmens in Forschung und Entwicklung sowie die gemeinsamen Bemühungen der weltweiten Aya-Gemeinschaft werden in den kommenden Jahren zweifellos zu weiteren Verbesserungen, Erweiterungen und Durchbrüchen führen.

Fazit

Die Aya-23-Modelle von Cohere For AI stellen einen bahnbrechenden Fortschritt in der Welt des mehrsprachigen NLP dar. Durch die Nutzung der Leistungsfähigkeit des Aya-Ökosystems haben diese Modelle neue Maßstäbe in Bezug auf Leistung, Zugänglichkeit und sprachliche Abdeckung gesetzt. Da die Forschungsgemeinschaft den Open-Source-Charakter der Aya-23-Modelle annimmt, verspricht die Zukunft der mehrsprachigen KI grenzenlose Innovation, Zusammenarbeit und die Stärkung verschiedener Sprachen und Kulturen weltweit zu sein.

Definitionen

- Aya-23-Modelle von Cohere: Eine von Cohere For AI entwickelte Reihe von hochmodernen mehrsprachigen Großsprachmodellen, die für die Verarbeitung verschiedener Sprachen und komplexer NLP-Aufgaben konzipiert sind.

- Verarbeitung natürlicher Sprache (NLP): Ein Bereich der künstlichen Intelligenz, der sich mit der Interaktion zwischen Computern und Menschen durch natürliche Sprache beschäftigt.

- LLM-Modelle: Große Sprachmodelle, die maschinelle Lerntechniken verwenden, um menschliche Sprache in großem Maßstab zu verstehen, zu erzeugen und zu übersetzen.

- KI-Ökosystem: Die vernetzte Umgebung von KI-Tools, Ressourcen und Forschung, die die Entwicklung und Anwendung von künstlicher Intelligenz unterstützt.

- Aya-Sammlung: Ein riesiger mehrsprachiger Datensatz mit 513 Millionen Aufforderungen und Vervollständigungen in 114 Sprachen, der zum Trainieren von Aya-23-Modellen verwendet wird.

- Gemma, Mistral und Mixtral: Andere weit verbreitete mehrsprachige Modelle, die von Aya-23 in verschiedenen NLP-Aufgaben übertroffen werden.

Häufig gestellte Fragen

- Was sind die Aya-23-Modelle von Cohere? Die Aya-23-Modelle von Cohere sind fortschrittliche, mehrsprachige Großsprachenmodelle, die für eine Vielzahl von Sprachen und NLP-Aufgaben entwickelt wurden. Sie sind in zwei Versionen erhältlich: Aya-23-8B und Aya-23-35B, mit 8 Milliarden bzw. 35 Milliarden Parametern.

- Inwiefern sind die Aya-23 Modelle besser als frühere Versionen wie Aya-101? Die Aya-23-Modelle weisen gegenüber Aya-101 erhebliche Verbesserungen auf. Sie sind leistungsfähiger bei Aufgaben wie dem Verstehen natürlicher Sprache, der Zusammenfassung und der Übersetzung. Sie bieten auch bessere mehrsprachige mathematische Argumentation und allgemeine linguistische Fähigkeiten.

- Was ist die Aya-Sammlung und wie unterstützt sie die Aya-23 Modelle? Die Aya-Sammlung ist ein umfassender mehrsprachiger Datensatz, der 513 Millionen Aufforderungen und Vervollständigungen in 114 Sprachen enthält. Sie dient als Trainingsgrundlage für die Aya-23 Modelle und ermöglicht es ihnen, bei verschiedenen mehrsprachigen Aufgaben zu brillieren.

- Warum ist die offene Version der Aya-23 Modelle so wichtig? Die offene Version ermöglicht es Forschern und Entwicklern, auf die Aya-23 Modelle zuzugreifen, sie zu verfeinern und darauf aufzubauen. Dadurch wird der Zugang zu modernster KI-Technologie demokratisiert und ein kollaboratives Umfeld für die Weiterentwicklung von mehrsprachigem NLP gefördert.

- Was unterscheidet die Aya-23 Modelle von anderen mehrsprachigen Modellen wie Gemma und Mistral? Die Aya-23 Modelle übertreffen Gemma, Mistral und andere mehrsprachige Modelle um bis zu 20% bei generativen Aufgaben und 41,6% bei mehrsprachigem mathematischem Denken. Sie gewährleisten eine gleichbleibende Qualität in allen Sprachen und sind sowohl für leistungsstarke als auch für zugängliche Anwendungsfälle konzipiert.