Last Updated on April 16, 2024 8:54 am by Laszlo Szabo / NowadAIs | Published on April 16, 2024 by Laszlo Szabo / NowadAIs

AI versteht Ihr Zuhause – Meta’s OpenEQA: Open-Vocabulary Embodied Question Answering Benchmark – Wichtige Hinweise

- Meta OpenEQA ist ein von Meta AI eingeführter Benchmark, mit dem das Verständnis von KI für physische Umgebungen anhand von Fragen mit offenem Vokabular bewertet wird.

- Er zielt darauf ab, Bildverarbeitungs- und Sprachmodelle (VLMs) zu verbessern, um eine menschenähnliche Leistung zu erreichen.

- Er besteht aus zwei Aufgaben: EQA für das episodische Gedächtnis und aktive EQA, die die Gedächtnisleistung der KI bzw. die Interaktion mit der Umgebung testen.

- Grundlegend für praktische Anwendungen wie die Unterstützung bei täglichen Aufgaben durch intelligente Geräte.

- Zeigt eine erhebliche Lücke zwischen der derzeitigen KI und dem menschlichen räumlichen Verständnis auf und unterstreicht die Notwendigkeit weiterer Fortschritte.

Einführung

Aufder Suche nach künstlicher allgemeiner Intelligenz (AGI) hat Meta AI, ein Unternehmen der Facebook-Muttergesellschaft, einen Benchmark namens Meta OpenEQA eingeführt. Dieser Open-Vocabulary Embodied Question Answering Benchmark zielt darauf ab, die Lücke zwischen aktuellen Vision- und Sprachmodellen (VLMs) und menschlicher Leistung beim Verstehen physischer Räume zu schließen. Der Benchmark bewertet die Fähigkeit eines KI-Agenten, seine Umgebung anhand von Fragen mit offenem Vokabular zu verstehen, und ebnet so den Weg für Fortschritte in der Künstlichen Intelligenz.

Der Bedarf an verkörperter KI

Stellen Sie sich eine Welt vor, in der KI-Agenten als Gehirn von Heimrobotern oder intelligenten Brillen fungieren und in der Lage sind, sensorische Modalitäten wie das Sehen zu nutzen, um Menschen zu verstehen und effektiv mit ihnen zu kommunizieren. Um dieses ehrgeizige Ziel zu erreichen, müssen KI-Agenten ein umfassendes Verständnis der Außenwelt entwickeln, das gemeinhin als

“Weltmodell”

Meta AI erkennt an, dass das Erreichen eines solchen Verständnisses eine gewaltige Forschungsherausforderung darstellt, die jedoch für die Entwicklung von AGI unerlässlich ist.

Herkömmliche Sprachmodelle haben erhebliche Fortschritte im Sprachverständnis gemacht, aber es fehlt ihnen an einem Echtzeitverständnis der Welt um sie herum. Meta-KI zielt darauf ab, diese Modelle durch die Einbeziehung visueller Informationen zu verbessern, damit sie ihre Umgebung besser verstehen und sinnvolle Antworten auf Benutzeranfragen geben können. Durch die Kombination von Bild und Sprache haben verkörperte KI-Agenten das Potenzial, verschiedene Bereiche zu revolutionieren, vom intelligenten Zuhause bis zu Wearables.

Einführung in Meta OpenEQA

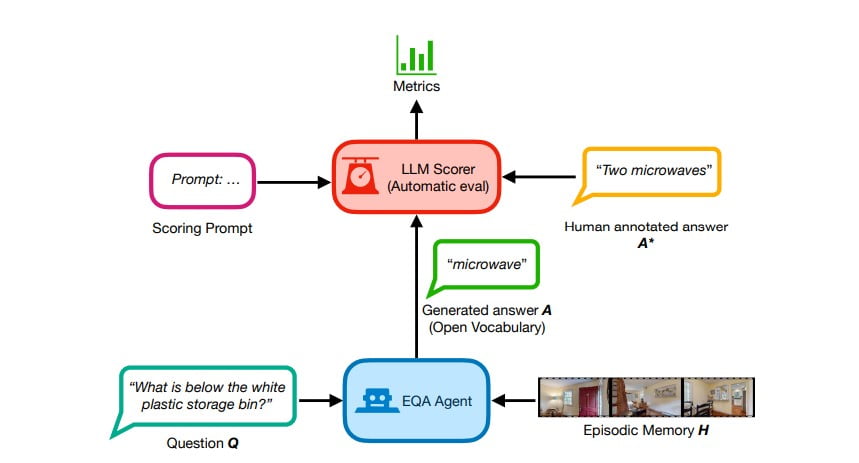

Mit dem Ziel, die verkörperte KI voranzutreiben, hat Meta AI das Open-Vocabulary Embodied Question Answering (OpenEQA) Framework eingeführt. Dieser Benchmark misst das Verständnis eines KI-Agenten für seine Umgebung, indem er ihm Fragen mit offenem Vokabular stellt. OpenEQA besteht aus zwei Aufgaben: EQA aus dem episodischen Gedächtnis und aktive EQA.

Bei der Episodic Memory EQA muss der KI-Agent Fragen beantworten, die auf seiner Erinnerung an vergangene Erfahrungen basieren. Diese Aufgabe testet die Fähigkeit des Agenten, relevante Informationen aus seinem Gedächtnis abzurufen, um genaue Antworten zu geben. Bei der aktiven EQA hingegen erkundet der KI-Agent aktiv seine Umgebung, um notwendige Informationen zu sammeln und Fragen zu beantworten. Bei dieser Aufgabe wird die Fähigkeit des Agenten bewertet, mit der physischen Welt zu interagieren und seine Umgebung zu nutzen, um Erkenntnisse zu gewinnen.

Die Bedeutung von EQA

Embodied Question Answering (EQA) hat über die Forschung hinaus immense praktische Auswirkungen. Selbst eine einfache Version von EQA kann das tägliche Leben vereinfachen. Stellen Sie sich zum Beispiel vor, Sie wollen das Haus verlassen, können aber Ihren Büroausweis nicht finden. Mit EQA können Sie einfach Ihre intelligente Brille oder Ihren Haushaltsroboter fragen, wo Sie ihn abgelegt haben, und der KI-Agent kann sein episodisches Gedächtnis nutzen, um Ihnen die Antwort zu geben. EQA hat das Potenzial, die Interaktion zwischen Mensch und Maschine zu verbessern und KI-Agenten zu unverzichtbaren Begleitern in unserem täglichen Leben zu machen.

Bei OpenEQA von Meta geht es nicht nur um praktische Anwendungen; es dient auch als Werkzeug, um das Weltverständnis eines KI-Agenten zu testen. Ähnlich wie wir das menschliche Verständnis beurteilen, bewertet OpenEQA die Fähigkeit eines KI-Agenten, Fragen präzise und kohärent zu beantworten. Mit der Veröffentlichung dieses Benchmarks möchte Meta AI die offene Forschung zur Verbesserung des Verständnisses und der Kommunikationsfähigkeiten von KI-Agenten motivieren und erleichtern – ein entscheidender Schritt auf dem Weg zu AGI.

Die Lücke zwischen VLMs und menschlicher Leistung

Meta AI hat mit Hilfe von OpenEQA ein umfangreiches Benchmarking von modernen Bildverarbeitungs- und Sprachmodellen (VLMs) durchgeführt. Die Ergebnisse zeigten eine Lücke zwischen der Leistung der besten VLMs und dem menschlichen Verständnis auf. Insbesondere bei Fragen, die ein räumliches Verständnis erfordern, erwiesen sich selbst die fortschrittlichsten VLMs als

“fast blind”

Mit anderen Worten: Der Zugang zu visuellen Inhalten verbesserte ihre Leistung im Vergleich zu reinen Sprachmodellen nicht wesentlich.

Zum Beispiel, wenn die Frage gestellt wurde,

“Ich sitze auf der Couch im Wohnzimmer und sehe fern. Welches Zimmer befindet sich direkt hinter mir?”,

gaben die Modelle zufällige Vermutungen ab, ohne das visuelle episodische Gedächtnis zu nutzen, das ein Verständnis für den Raum vermitteln sollte. Dies deutet darauf hin, dass sowohl die Wahrnehmungs- als auch die Schlussfolgerungsfähigkeiten von VLMs weiter verbessert werden müssen, bevor verkörperte KI-Agenten, die auf diesen Modellen basieren, für den breiten Einsatz bereit sind.

Metas OpenEQA: Ein neuartiger Benchmark für verkörperte KI

Meta’s OpenEQA setzt einen neuen Standard bei der Bewertung der Leistung von verkörperten KI-Agenten. Es ist der erste Open-Vocabulary-Benchmark für EQA, der Forschern ein umfassendes Rahmenwerk zur Messung und Verfolgung von Fortschritten in den Bereichen multimodales Lernen und Szenenverständnis bietet. Der Benchmark umfasst über 1.600 nicht-templierte Frage-Antwort-Paare, die repräsentativ für reale Anwendungsfälle sind und von menschlichen Kommentatoren validiert wurden. Darüber hinaus enthält er mehr als 180 Videos und Scans von physischen Umgebungen, die es KI-Agenten ermöglichen, mit realistischen Szenarien zu interagieren.

Um die von KI-Agenten generierten Antworten mit offenem Vokabular zu bewerten, führt Meta’s OpenEQA LLM-Match ein, eine automatische Bewertungsmetrik. In Blindstudien hat Meta AI herausgefunden, dass LLM-Match eng mit menschlichen Urteilen korreliert, was seine Effektivität als Bewertungskriterium beweist. Die umfassende Natur des Benchmarks und die robuste Bewertungsmetrik geben Forschern ein zuverlässiges Werkzeug an die Hand, um die Leistung ihrer Modelle zu messen und Bereiche mit Verbesserungsbedarf zu identifizieren.

Fortschritte bei der verkörperten KI mit OpenEQA von Meta

Metas OpenEQA ist eine Entwicklung, die den Weg für Fortschritte in der verkörperten KI ebnet. Durch die Bereitstellung eines Benchmarks, der das Verständnis eines KI-Agenten für seine Umgebung bewertet, ermutigt Meta AI Forscher, ein besseres räumliches Verständnis und effektive Kommunikationsfähigkeiten anzustreben. Der Fokus des Benchmarks auf Fragen mit offenem Wortschatz und realen Szenarien ermöglicht es Forschern, KI-Agenten zu entwickeln, die sich in der physischen Welt ähnlich wie Menschen bewegen und mit ihr interagieren können.

Meta AI arbeitet aktiv an der Entwicklung von Weltmodellen, die in der Lage sind, bei OpenEQA gut abzuschneiden, und lädt Forscher auf der ganzen Welt ein, sich ihnen bei diesem Vorhaben anzuschließen. Die offizielle Freigabe des Benchmarks bildet die Grundlage für gemeinsame Forschung und Innovation , die die Grenzen der KI verschiebt und uns der Verwirklichung einer allgemeinen künstlichen Intelligenz näher bringt.

Definitionen

- Meta: Meta, ehemals Facebook, ist ein Technologiekonglomerat, das dafür bekannt ist, die Grenzen der sozialen Medien, der virtuellen Realität und der Forschung im Bereich der künstlichen Intelligenz zu verschieben.

- Künstliche generative Intelligenz: Dies bezieht sich auf KI-Systeme, die auf der Grundlage von Trainingsdaten aus großen Datenbeständen menschenähnliche Texte, Bilder oder Ideen generieren können.

- Meta’s OpenEQA: Ein von Meta AI entwickelter Benchmark für die Beantwortung von Fragen mit offenem Vokabular, um das Verständnis der KI für und die Interaktion mit ihrer physischen Umgebung zu bewerten und zu verbessern.

- Seh- und Sprachmodelle (VLMs): KI-Systeme, die visuelle Verarbeitung mit Sprachverständnis verbinden, um multimodale Eingaben zu interpretieren und darauf zu reagieren.

- Meta AI: Eine Abteilung von Meta, die sich der Weiterentwicklung der KI-Technologie widmet und sich auf die Entwicklung von Modellen zur Verbesserung der Interaktion und des Verständnisses zwischen Mensch und KI konzentriert.

Häufig gestellte Fragen

- Was ist Meta’s OpenEQA und wie wirkt es sich auf die KI-Forschung aus? Meta OpenEQA ist ein Benchmark-Tool, das von Meta AI entwickelt wurde, um die Fähigkeit von KI-Agenten zu testen und zu verbessern, ihre physische Umgebung anhand von Fragen mit offenem Wortschatz zu verstehen und mit ihr zu interagieren. Es dient als entscheidender Schritt zur Entwicklung von KI, die in der realen Welt effektiv arbeiten kann.

- Warum ist die Entwicklung von Metas OpenEQA so wichtig für die Zukunft intelligenter Geräte? Durch die Verbesserung des Verständnisses von KI für räumliche Umgebungen ebnet Meta’s OpenEQA den Weg für intelligentere, intuitivere KI-Agenten in Geräten wie Robotern und intelligenten Brillen, wodurch die Technologie bei alltäglichen Aufgaben hilfreicher wird.

- Wie unterscheidet sich Meta’s OpenEQA von herkömmlichen KI-Benchmarks? Im Gegensatz zu herkömmlichen Benchmarks, die sich entweder auf das sprachliche oder das visuelle Verständnis konzentrieren, kombiniert Metas OpenEQA diese Elemente, um das multimodale Verständnis und die Interaktion von KI in einer 3D-Umgebung zu bewerten.

- Welchen Herausforderungen begegnet Meta’s OpenEQA auf dem Gebiet der künstlichen Intelligenz? Meta’s OpenEQA befasst sich mit der Herausforderung, eine KI zu entwickeln, die den Kontext verstehen und Aufgaben ähnlich wie der Mensch ausführen kann, insbesondere bei der Navigation und Reaktion auf reale Umgebungen.

- Welche zukünftigen Fortschritte können wir von Metas OpenEQA erwarten? Mit der Weiterentwicklung von Meta’s OpenEQA können wir Fortschritte erwarten, die zu KI-Modellen mit besserem räumlichen Bewusstsein und effektiveren Kommunikationsfähigkeiten führen, die für den praktischen Einsatz von KI in Alltagsszenarien unerlässlich sind.