Last Updated on Juni 10, 2024 10:57 am by Laszlo Szabo / NowadAIs | Published on Juni 10, 2024 by Laszlo Szabo / NowadAIs

Qwen 2-72B von Alibaba Cloud – Das KI-Kraftpaket schlägt Top-LLM-Modelle wie Llama-3-70B – Wichtige Hinweise

- Qwen 2-72B ist das Flaggschiff unter den großen Sprachmodellen, die vom Qwen-Team bei Alibaba Cloud entwickelt wurden

- Es bietet Spitzenleistungen in den Bereichen Sprachverständnis, Mehrsprachigkeit, Kodierung, Mathematik und logisches Denken

- Das Modell verfügt über fortschrittliche architektonische Elemente wie SwiGLU-Aktivierung, Aufmerksamkeits-QKV-Bias und Aufmerksamkeit bei Gruppenabfragen

- Qwen 2-72B wurde mit umfangreichen mehrsprachigen Daten trainiert und durch überwachtes Finetuning und direkte Präferenzoptimierung verfeinert

- Es unterstützt Kontextlängen von bis zu 128K Token, was eine außergewöhnliche Handhabung von langen Inhalten ermöglicht

- Das Modell weist eine überragende Sicherheit und Verantwortlichkeit auf und übertrifft führende Alternativen im Umgang mit sensiblen Prompts

Einführung

In der sich schnell entwickelnden Landschaft der künstlichen Intelligenz stellt die Vorstellung von Qwen 2-72B einen monumentalen Meilenstein dar. Dieses kolossale große Sprachmodell, das vom visionären Qwen-Team bei Alibaba Cloud entwickelt wurde, hat sich als wahre Meisterleistung entpuppt und setzt erstaunlich hohe Maßstäbe für Sprachverständnis, Mehrsprachigkeit und Aufgabenlösungsfähigkeit.

Qwen 2-72B ist der Höhepunkt akribischer Forschung, rigorosen Trainings und eines unermüdlichen Strebens nach Spitzenleistungen. Mit seinen erstaunlichen 72 Milliarden Parametern wurde dieses riesige Modell sorgfältig entwickelt, um in einer Vielzahl von Bereichen hervorragende Leistungen zu erbringen, von der Verarbeitung natürlicher Sprache und der Codegenerierung bis hin zum mathematischen Denken und darüber hinaus.

Mehrsprachige Beherrschung

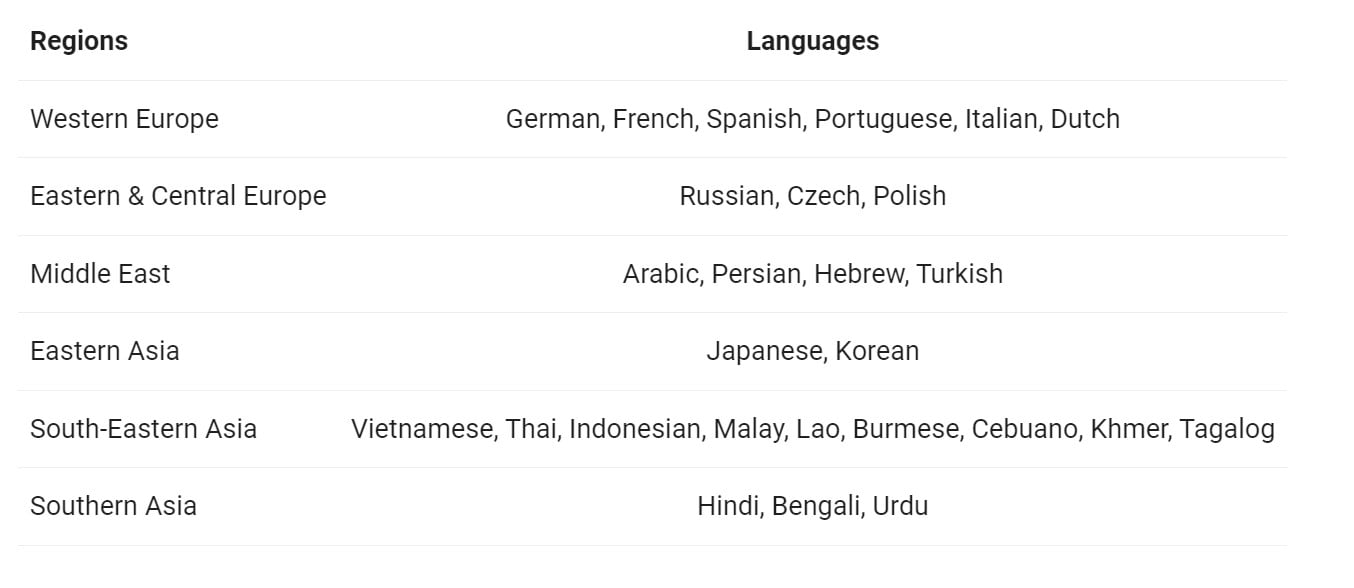

Eine der herausragenden Eigenschaften von Qwen 2-72B sind seine außergewöhnlichen mehrsprachigen Fähigkeiten. Das Modell wurde auf einem umfangreichen Datensatz trainiert, der neben Englisch und Chinesisch 27 weitere Sprachen umfasst, und hat so ein tiefes und vielseitiges Verständnis für verschiedene Sprachlandschaften entwickelt. Diese sprachliche Vielseitigkeit ermöglicht es Qwen 2-72B, nahtlos durch die sprachübergreifende Kommunikation zu navigieren, Barrieren abzubauen und die globale Zusammenarbeit zu fördern.

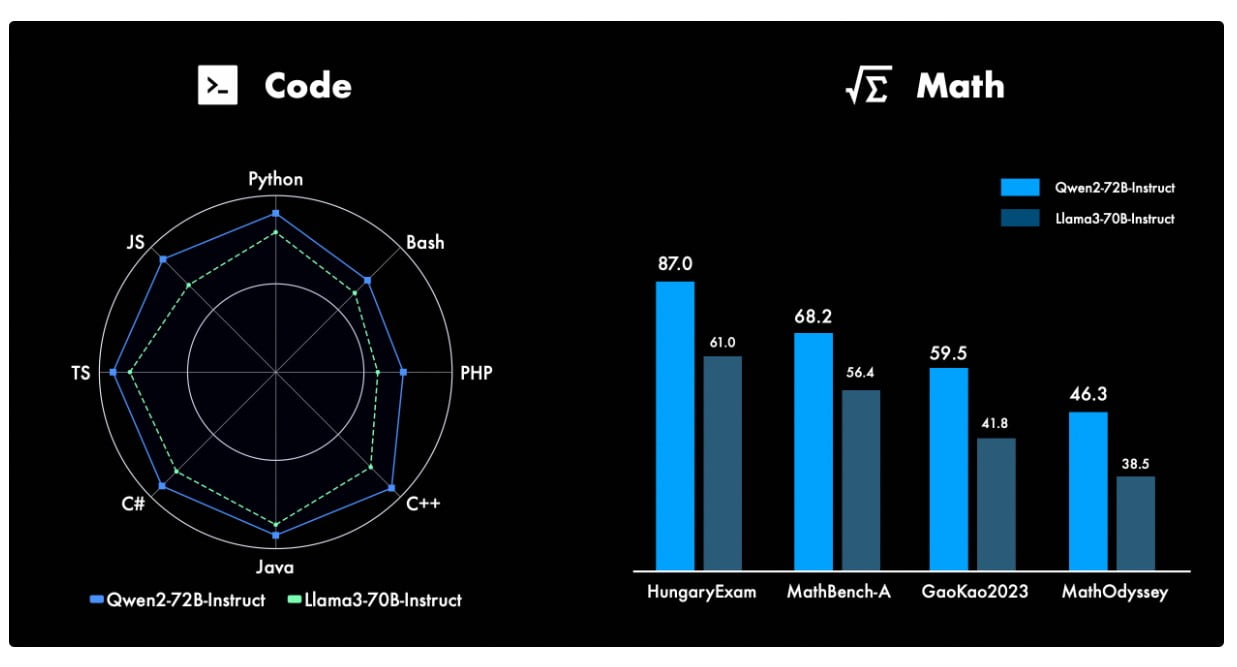

Codierung und mathematische Fähigkeiten

Die Fähigkeiten von Qwen 2-72B gehen weit über den Bereich der natürlichen Sprachverarbeitung hinaus. Das Modell hat bemerkenswerte Fähigkeiten in den Bereichen Kodierung und Mathematik bewiesen und damit neue Maßstäbe in diesen hochtechnischen Bereichen gesetzt. Durch sorgfältiges Training und gezielte Verfeinerung hat das Qwen-Team dem Modell ein tiefes Verständnis von Programmiersprachen, Algorithmen und mathematischen Konzepten vermittelt, so dass es in der Lage ist, komplexe Codierungsaufgaben zu bewältigen und komplizierte mathematische Probleme mit Leichtigkeit zu lösen.

Beherrschung von Langform-Inhalten

Eines der herausragenden Merkmale des Qwen 2-72B ist seine außergewöhnliche Fähigkeit, lange Inhalte zu verarbeiten. Das Modell ist in der Lage, Kontextlängen von bis zu 128.000 Token zu verarbeiten und zeichnet sich dadurch aus, dass es umfangreiche, mehrteilige Eingaben versteht und kohärente Antworten erzeugt. Diese Fähigkeit zeichnet Qwen 2-72B aus und macht es zu einer wertvollen Ressource für Anwendungen, bei denen ein detailliertes, nuanciertes Verständnis langer Texte von größter Bedeutung ist.

Sicherheit und Verantwortung

In einer Zeit, in der die verantwortungsbewusste Entwicklung von KI-Technologien von größter Bedeutung ist, zeichnet sich Qwen 2-72B durch sein unerschütterliches Engagement für Sicherheit und ethische Überlegungen aus. Ausführliche Tests haben gezeigt, dass das Modell in der Lage ist, mit sensiblen Eingabeaufforderungen und Inhalten umzugehen und durchgängig Ergebnisse zu produzieren, die mit menschlichen Werten übereinstimmen und frei von schädlichen oder unethischen Elementen sind.

Qwen 2-72B in Aktion

Die Vielseitigkeit von Qwen 2-72B ist wirklich atemberaubend. Das Modell ist in der Lage, nahtlos zwischen einer Vielzahl von Aufgaben und Anwendungen zu wechseln. Von der Generierung natürlicher Sprache und der Beantwortung von Fragen bis hin zur Interpretation von Code und der Lösung mathematischer Probleme hat sich dieses KI-Kraftpaket als wahrer Alleskönner erwiesen.

Einsatz und Integration

Qwen 2-72B wurde mit Blick auf Skalierbarkeit und Zugänglichkeit entwickelt und ist damit ein erstklassiger Kandidat für den Einsatz auf einer Vielzahl von Plattformen und Anwendungsfällen. Die Integration des Modells in führende Frameworks wie Hugging Face Transformers und ModelScope stellt sicher, dass Entwickler und Forscher die Fähigkeiten des Modells mühelos nutzen können, um neue Möglichkeiten in ihren jeweiligen Bereichen zu erschließen.

Benchmarking und Leistung

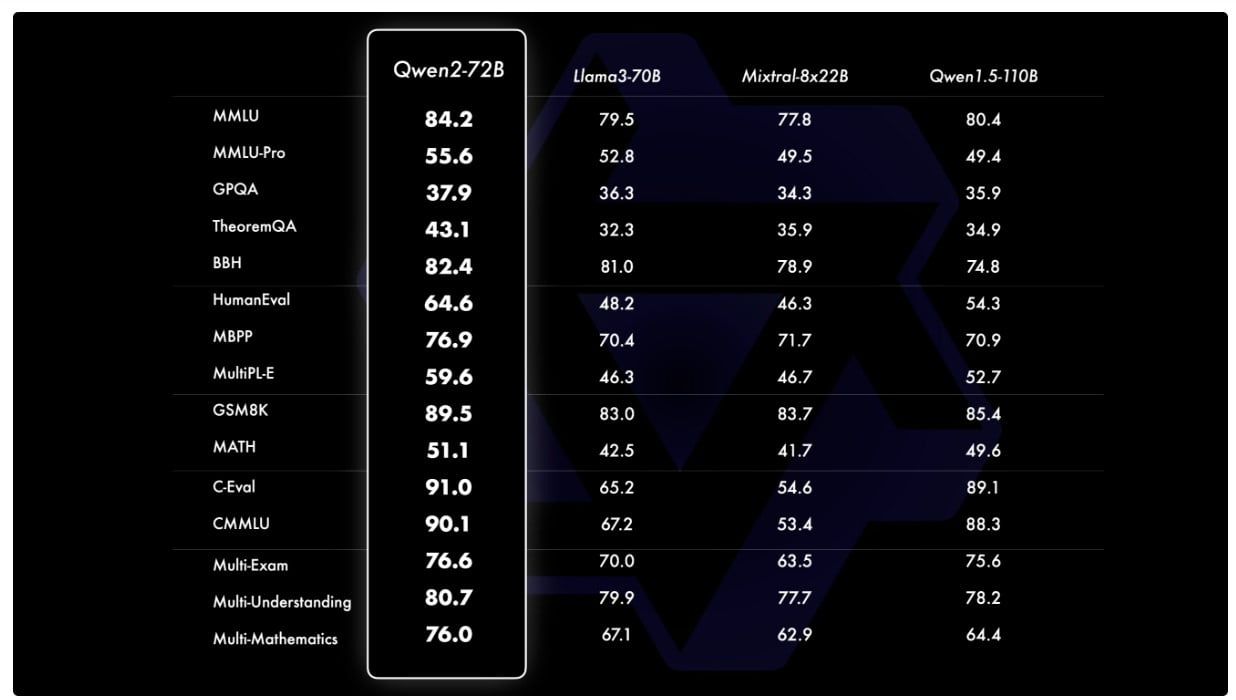

Strenge Tests und Bewertungen haben die überragende Leistung von Qwen 2-72B bei einer Vielzahl von Benchmarks immer wieder bestätigt. Im direkten Vergleich mit anderen State-of-the-Art-Modellen, wie z.B. Llama-3-70B, hat sich das Qwen 2-72B-Modell als klarer Spitzenreiter erwiesen und seine unvergleichlichen Fähigkeiten in Bereichen wie natürliches Sprachverständnis, Wissenserwerb und Aufgabenlösungsfähigkeit unter Beweis gestellt.

Der Weg in die Zukunft

Da das Qwen 2-72B-Modell die KI-Gemeinschaft weiterhin in seinen Bann zieht, ist die Zukunft äußerst vielversprechend. Das unerschütterliche Engagement des Qwen-Teams für Innovation und sein unermüdliches Streben nach Spitzenleistungen lassen vermuten, dass dies erst der Anfang einer neuen Ära in der Entwicklung großer Sprachmodelle ist. Mit fortlaufenden Verfeinerungen, Erweiterungen und der Erforschung multimodaler Fähigkeiten ist Qwen 2-72B bereit, die Grenzen dessen, was in der Welt der künstlichen Intelligenz möglich ist, neu zu definieren.

Definitionen

- Qwen 2-72B: Ein von Alibaba Cloud entwickeltes, hochmodernes, großes Sprachmodell mit 72 Milliarden Parametern, das sich durch mehrsprachige Fähigkeiten, Codierung, Mathematik und die Verarbeitung langer Inhalte auszeichnet.

- SwiGLU: Eine Art von Aktivierungsfunktion, die in neuronalen Netzen verwendet wird und die Fähigkeit des Modells zum Erlernen komplexer Muster verbessert.

- QKV-Verzerrung: Bezieht sich auf die Verzerrungsterme in den Abfrage-, Schlüssel- und Wertvektoren in Transformer-Modellen, die die Aufmerksamkeitsmechanismen verbessern.

- HungaryExam: Ein Benchmarking-Datensatz oder -Tool, das zur Bewertung der Leistung von KI-Modellen beim Sprachverstehen und bei verwandten Aufgaben verwendet wird.

- MMLU-Leistungsmetriken: Metriken zur Bewertung der Leistung großer Sprachmodelle beim Massive Multitask Language Understanding (MMLU) Benchmark.

- MIxtral-8x LLM-Modell: Ein weiteres großes Sprachmodell, das als Vergleichspunkt für die Bewertung der Fähigkeiten von Qwen 2-72B dient.

- SwiGLU-Aktivierung: Eine spezielle Aktivierungsfunktion, die in Qwen 2-72B verwendet wird und zu dessen fortgeschrittenen Lernfähigkeiten beiträgt.

- QKV Bias: Verzerrungsbegriffe, die den Abfrage-, Schlüssel- und Wertprojektionen in Aufmerksamkeitsmechanismen hinzugefügt werden, um die Modellleistung zu verbessern.

Häufig gestellte Fragen

F: Wodurch hebt sich Qwen 2-72B von anderen großen Sprachmodellen ab? A: Qwen 2-72B zeichnet sich durch mehrere wichtige Unterscheidungsmerkmale aus, darunter seine hochmoderne Architektur, seine außergewöhnlichen mehrsprachigen Fähigkeiten und seine unvergleichliche Leistung bei der Codierung und Mathematik. Darüber hinaus hebt sich das Modell durch seine Fähigkeit, lange Inhalte mit bis zu 128.000 Token zu verarbeiten, sowie durch sein starkes Engagement für Sicherheit und verantwortungsvolle Entwicklung von der Konkurrenz ab.

F: Wie ist die Leistung des Qwen 2-72B im Vergleich zu anderen führenden Modellen? A: Strenge Leistungsvergleiche haben immer wieder gezeigt, dass der Qwen 2-72B anderen modernen Modellen, wie dem Llama-3-70B, überlegen ist. Das Modell Qwen 2-72B hat seine Konkurrenten in einem breiten Spektrum von Bewertungen übertroffen, einschließlich des Verständnisses natürlicher Sprache, der Wissenserfassung und der Fähigkeit zur Aufgabenlösung.

F: Welches sind die wichtigsten architektonischen Innovationen, die die beeindruckenden Fähigkeiten von Qwen 2-72B ermöglichen? A: Qwen 2-72B beinhaltet architektonische Elemente wie SwiGLU-Aktivierung, Aufmerksamkeits-QKV-Bias und Gruppenabfrage-Attention. Diese Weiterentwicklungen verbessern nicht nur die reine Rechenleistung des Modells, sondern verleihen ihm auch ein differenziertes Verständnis von Sprache, sodass es selbst die komplexesten und mehrdeutigsten Aufgaben mit beispielloser Präzision bewältigen kann.

F: Wodurch zeichnet sich die Mehrsprachigkeit von Qwen 2-72B aus? A: Die außergewöhnliche Mehrsprachigkeit von Qwen 2-72B ist ein Beleg für das Engagement des Qwen-Teams, die globale Zusammenarbeit zu fördern und sprachliche Barrieren zu überwinden. Das Modell wurde auf einem umfangreichen Datensatz trainiert, der neben Englisch und Chinesisch noch 27 weitere Sprachen umfasst, und hat so ein tiefes und vielseitiges Verständnis der verschiedenen Sprachlandschaften entwickelt, das es ihm ermöglicht, nahtlos durch die sprachübergreifende Kommunikation zu navigieren.

F: Welche Maßnahmen wurden ergriffen, um die Sicherheit und Verantwortung von Qwen 2-72B zu gewährleisten? A: Das Qwen-Team hat großen Wert auf die verantwortungsvolle Entwicklung von Qwen 2-72B gelegt. Ausführliche Tests haben gezeigt, dass das Modell in der Lage ist, mit sensiblen Aufforderungen und Inhalten umzugehen und konsistent Ergebnisse zu produzieren, die mit menschlichen Werten übereinstimmen und frei von schädlichen oder unethischen Elementen sind. Dieses Engagement für Sicherheit und ethische Überlegungen macht Qwen 2-72B zu einer verantwortungsvollen und vertrauenswürdigen KI-Lösung.